预计阅读时间: 5 分钟

本指南将向您展示如何在 Windows、Linux 或 macOS 上本地运行大型语言模型(LLMs),无需使用 Docker。Ollama 提供本地模型推理,Open WebUI 是一个简化与这些模型交互的用户界面。体验类似于使用 ChatGPT、Google Gemini 或 Claude AI 等界面。

无需 Docker 运行 Open WebUI 可以更高效地利用您的计算机资源。在没有容器化环境限制的情况下,所有可用的系统内存、CPU 功率和存储都可以完全用于运行应用程序。这在处理资源密集型模型时尤为重要,每一份性能都至关重要。

例如,如果您使用 Open WebUI 与大型语言模型交互,本地执行可以实现更快的处理时间和更流畅的性能,因为没有 Docker 管理容器的开销。本地运行还可以带来以下优势:

在开始之前,请确保您的系统已安装以下内容:

请确保您使用的是 Python 3.11.X。例如,版本 3.11.6 运行良好。最新版本 Python 3.12.7 与当前版本的 Open WebUI 不兼容。

您可以在 这里 下载 Python。请确保选择适合您操作系统的版本。Python 是一种广泛用于 AI 和机器学习的多功能编程语言,包括大型语言模型 (LLMs) 的开发和运行。如果您希望提升这方面的技能,请务必查看我们的 Python 闪卡,以快速高效地学习。

您可以使用 Python 的包管理器 pip 来安装 Open WebUI。按照以下步骤操作:

打开终端并运行以下命令以安装 Open WebUI:

pip install open-webui安装完成后,通过运行以下命令将 pip 更新到最新版本:

python.exe -m pip install --upgrade pip安装完成后,使用以下命令启动 Open WebUI 服务器:

open-webui serve成功启动 Open WebUI 后,您可以在浏览器中访问:http://localhost:8080。

此外,如果您愿意,可以通过直接从 GitHub 克隆项目来安装 Open WebUI。有关更多详细信息,请参阅本指南末尾的章节。

默认情况下,Ollama 为您的系统设置以下路径以存储语言模型 (LLMs):

~/.ollama/models/usr/share/ollama/.ollama/modelsC:\Users\%username%\.ollama\models如果需要,您可以更改此路径。例如,在 Windows 上使用以下命令:

setx OLLAMA_MODELS "D:\ollama_models"如果您以 macOS 应用程序形式运行 Ollama,应使用 launchctl 设置环境变量。使用以下命令设置变量:

launchctl setenv OLLAMA_MODELS "/new/path/to/models"设置变量后,重新启动 Ollama 应用程序以使更改生效。

对于以 systemd 服务形式运行 Ollama 的 Linux 用户,可以使用 systemctl 设置环境变量。操作方法如下:

通过运行以下命令打开服务配置:

sudo systemctl edit ollama.service在 [Service] 部分下添加以下行:

Environment="OLLAMA_MODELS=/new/path/to/models"保存文件,然后重新加载 systemd 并重新启动服务:

sudo systemctl daemon-reload

sudo systemctl restart ollama要在 Ollama 中下载和运行语言模型,请在终端中使用以下命令。这些命令将在模型尚未安装时自动下载:

下载并运行 Meta (Facebook) 提供的 LLaMA 3.1 模型:

ollama run llama3.1下载并运行 Google 提供的 Gemma 2 模型:

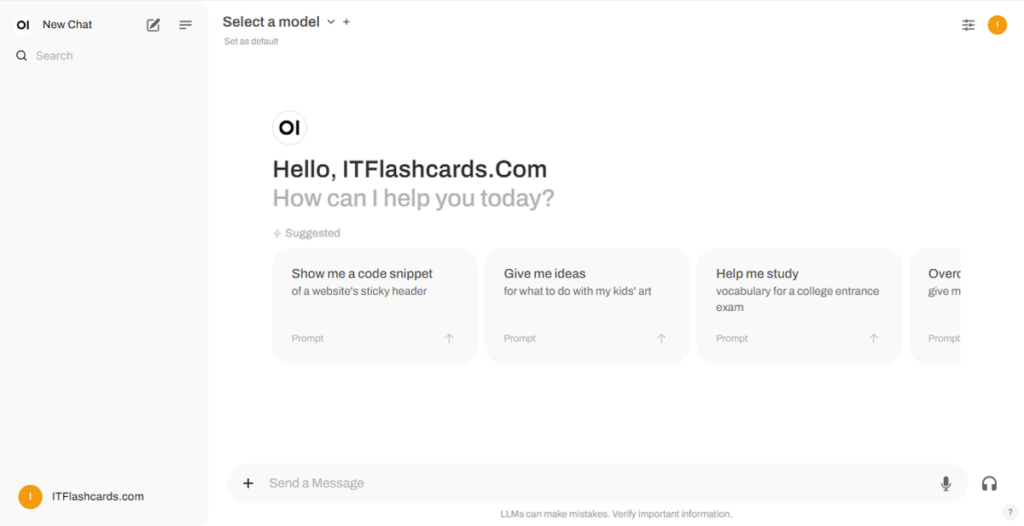

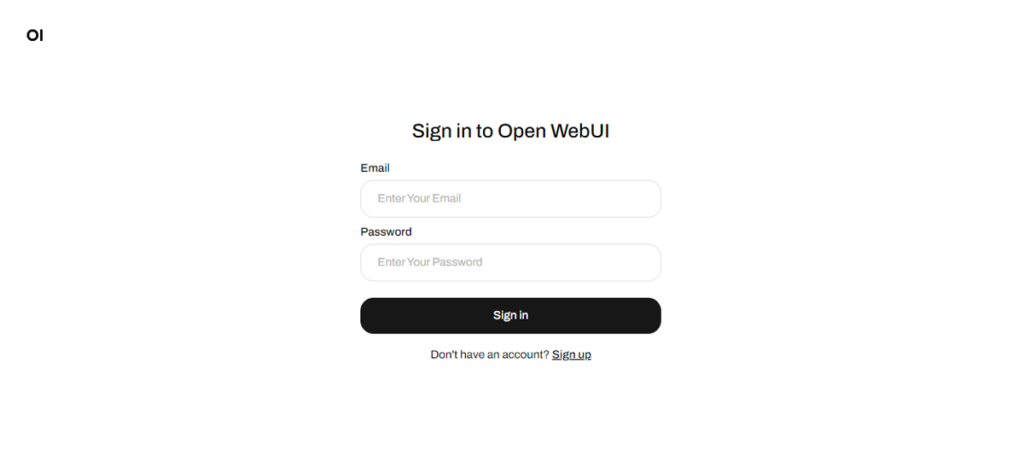

ollama run gemma2Open WebUI 运行后,您可以通过 http://localhost:8080 访问。在访问此地址后,系统将提示您登录或注册。要创建新帐户,请选择“注册”选项。此帐户仅在本机创建,系统上的其他用户无法访问您的数据。

如果您之前启动了 Open WebUI,但通过 Ollama 下载的模型未出现在列表中,请刷新页面以更新可用模型。Open WebUI 管理的所有数据都存储在本地设备上,确保您的模型和交互数据的隐私和控制。

如果您想通过从 GitHub 克隆项目并手动管理来安装 Open WebUI,请按照以下步骤操作:

打开终端并导航到要克隆存储库的目录。

使用 Git 克隆 Open WebUI 存储库:

git clone https://github.com/open-webui/open-webui.git切换到项目目录:

cd open-webui/复制 .env 文件:

cp -RPp .env.example .env使用 Node.js 构建前端:

npm install

npm run build进入 backend 目录:

cd ./backend(可选)创建并激活 Conda 环境:

conda create --name open-webui-env python=3.11

conda activate open-webui-env安装 Python 依赖项:

pip install -r requirements.txt -U启动应用程序:

bash start.sh打开终端并导航到要克隆存储库的目录。

使用 Git 克隆 Open WebUI 存储库:

git clone https://github.com/open-webui/open-webui.git切换到项目目录:

cd open-webui复制 .env 文件:

copy .env.example .env使用 Node.js 构建前端:

npm install

npm run build进入 backend 目录:

cd .\backend(可选)创建并激活 Conda 环境:

conda create --name open-webui-env python=3.11

conda activate open-webui-env安装 Python 依赖项:

pip install -r requirements.txt -U启动应用程序:

start_windows.bat通过遵循本指南,您应该可以在本地成功运行 Ollama 和 Open WebUI(无需 Docker)。如果在此过程中遇到任何错误或困难,请随时发表评论,我将尽力为您提供帮助。

Ollama + Open WebUI:在 Windows、Linux 或 macOS 上本地运行 LLM 的方法(无需 Docker)