tarafından Szymon Bodych

2024-10-08

Tahmini okuma süresi: 5 minutes

Bu kılavuz, Ollama ve Open WebUI kullanarak Windows, Linux veya macOS'ta Docker'a ihtiyaç duymadan büyük dil modellerini (LLM'leri) yerel olarak nasıl kurup çalıştırabileceğinizi kolayca gösterecektir. Ollama, yerel model çıkarımı sağlar ve Open WebUI, bu modellerle etkileşimi kolaylaştıran bir kullanıcı arayüzüdür. Deneyim, ChatGPT, Google Gemini veya Claude AI gibi arayüzlere benzer.

Open WebUI'ı Docker olmadan çalıştırmak, bilgisayarınızın kaynaklarını daha verimli kullanmanızı sağlar. Kapsayıcı ortamlarının sınırlamaları olmadan, mevcut tüm sistem belleği, CPU gücü ve depolama, uygulamayı çalıştırmaya tamamen ayrılabilir. Bu, özellikle kaynak yoğun modellerle çalışırken her performans artışının önemli olduğu durumlarda önemlidir.

Örneğin, büyük dil modelleriyle etkileşim kurmak için Open WebUI'ı kullanıyorsanız, yerel çalıştırma, Docker'ın kapsayıcıyı yönetmesinden kaynaklanan ek yük olmadığı için daha hızlı işlem süreleri ve daha sorunsuz bir performans sağlayabilir. Yerel olarak çalıştırarak ayrıca şu avantajları elde edersiniz:

Başlamadan önce, sisteminizde aşağıdaki bileşenlerin kurulu olduğundan emin olun:

Python 3.11.X sürümünü kullandığınızdan emin olun. Örneğin, 3.11.6 sürümü iyi çalışıyor. Python'un en son sürümü olan 3.12.7, mevcut Open WebUI sürümüyle uyumlu değildir.

Python'u buradan indirebilirsiniz. İşletim sisteminize uygun sürümü seçtiğinizden emin olun. Python, AI ve makine öğrenimi de dahil olmak üzere büyük dil modellerinin (LLM'ler) geliştirilmesi ve çalıştırılmasında yaygın olarak kullanılan çok yönlü bir programlama dilidir. Bu alanda becerilerinizi geliştirmek istiyorsanız, hızlı ve verimli bir öğrenme yöntemi için python flash kartlarımızı mutlaka inceleyin.

Open WebUI'ı kurmak için Python'un paket yöneticisi pip'i kullanabilirsiniz. Şu adımları izleyin:

Terminalinizi açın ve Open WebUI'ı kurmak için şu komutu çalıştırın:

pip install open-webuiKurulumdan sonra, pip'i en son sürüme güncellemek için şu komutu çalıştırın:

python.exe -m pip install --upgrade pipOpen WebUI yüklendikten sonra, sunucuyu şu komutla başlatın:

open-webui serveOpen WebUI başarıyla başlatıldıktan sonra, tarayıcınızda şu adrese erişebilirsiniz: http://localhost:8080.

Ayrıca, isterseniz Open WebUI'ı doğrudan GitHub'dan projeyi klonlayarak da yükleyebilirsiniz. Daha fazla ayrıntı için kılavuzun son bölümüne bakın.

Varsayılan olarak, Ollama dil modellerini (LLM'ler) sisteminizde şu yollarda depolar:

~/.ollama/models/usr/share/ollama/.ollama/modelsC:\Users\%username%\.ollama\modelsGerekirse bu yolu değiştirebilirsiniz. Örneğin, Windows'ta şu komutu kullanın:

setx OLLAMA_MODELS "D:\ollama_models"Ollama'yı bir macOS uygulaması olarak çalıştırıyorsanız, ortam değişkenleri launchctl kullanılarak ayarlanmalıdır. Bir değişken ayarlamak için şu komutu kullanın:

launchctl setenv OLLAMA_MODELS "/new/path/to/models"Değişkeni ayarladıktan sonra, değişikliklerin geçerli olması için Ollama uygulamasını yeniden başlatın.

Linux'ta Ollama'yı bir systemd servisi olarak çalıştıran kullanıcılar için, ortam değişkenleri systemctl kullanılarak ayarlanabilir. İşte bunu nasıl yapacağınız:

Hizmet yapılandırmasını açmak için şu komutu çalıştırın:

sudo systemctl edit ollama.service[Service] bölümüne şu satırı ekleyin:

Environment="OLLAMA_MODELS=/new/path/to/models"Dosyayı kaydedin, ardından systemd'yi yeniden yükleyin ve servisi yeniden başlatın:

sudo systemctl daemon-reloadsudo systemctl restart ollamaOllama'da dil modellerini indirmek ve çalıştırmak için terminalde şu komutları kullanın. Bu komutlar, model zaten yüklü değilse otomatik olarak indirilecektir:

Meta (Facebook) tarafından geliştirilen LLaMA 3.1 modelini indirmek ve çalıştırmak için:

ollama run llama3.1Google'dan Gemma 2 modelini indirmek ve çalıştırmak için:

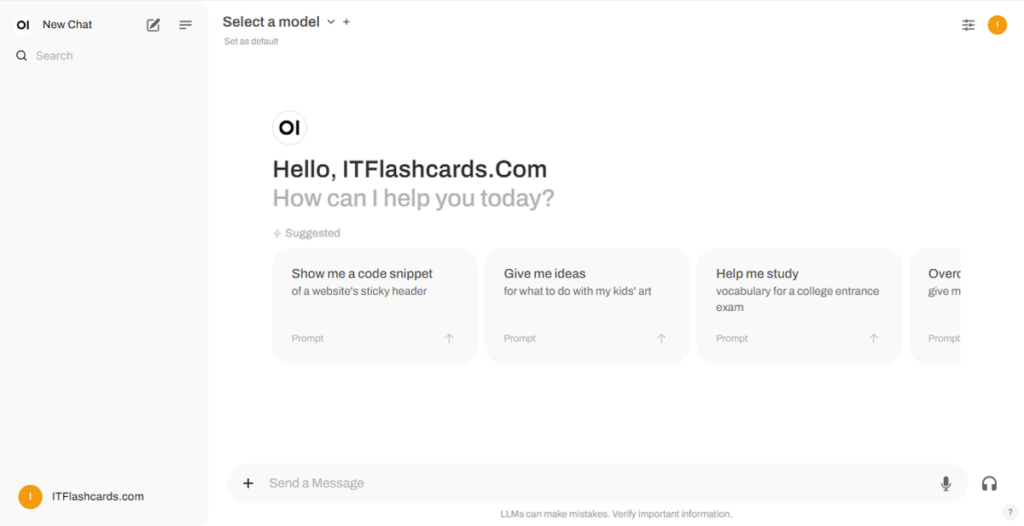

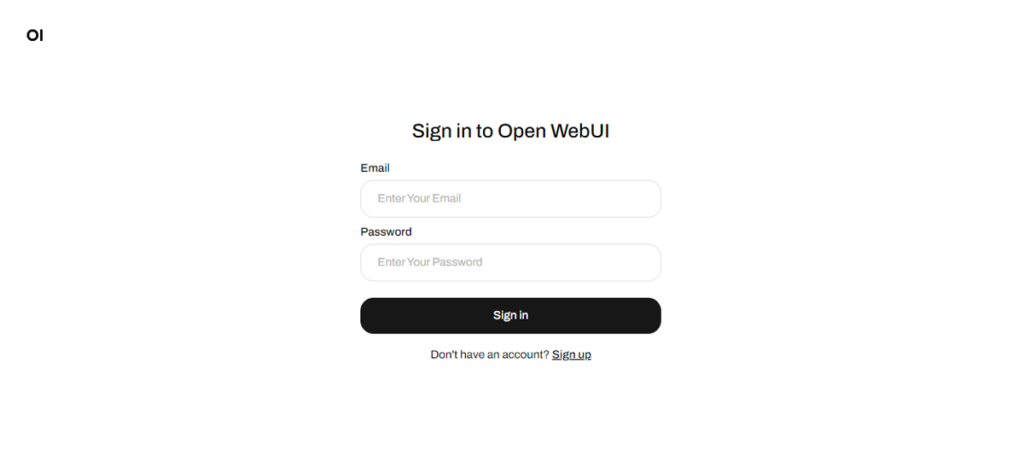

ollama run gemma2Open WebUI çalıştıktan sonra, http://localhost:8080 adresine erişebilirsiniz. Bu adrese girdikten sonra, giriş yapmanız veya kayıt olmanız istenir. Yeni bir hesap oluşturmak için "Kayıt Ol" seçeneğini seçin. Bu hesap yerel olarak oluşturulur, yani yalnızca bu makinede kullanılabilir ve sisteminizdeki başka bir kullanıcı verilerinize erişemez.

Daha önce Open WebUI'ı başlattıysanız ve Ollama üzerinden indirilen modeller listede görünmüyorsa, kullanılabilir modelleri güncellemek için sayfayı yenileyin. Open WebUI içerisinde yönetilen tüm veriler, cihazınızda yerel olarak depolanır, böylece modelleriniz ve etkileşimleriniz üzerinde gizlilik ve kontrol sağlanır.

Open WebUI'ı GitHub'dan projeyi klonlayarak manuel olarak yüklemek isterseniz, şu adımları izleyin:

Bir terminal açın ve projeyi klonlamak istediğiniz dizine gidin.

Open WebUI deposunu Git ile klonlayın:

git clone https://github.com/open-webui/open-webui.gitProje dizinine geçin:

cd open-webui/.env dosyasını kopyalayın:

cp -RPp .env.example .envFrontend'i Node.js ile derleyin:

npm installnpm run buildbackend dizinine geçin:

cd ./backend(İsteğe bağlı) Bir Conda ortamı oluşturun ve etkinleştirin:

conda create --name open-webui-env python=3.11conda activate open-webui-envPython bağımlılıklarını yükleyin:

pip install -r requirements.txt -UUygulamayı başlatın:

bash start.shBir terminal açın ve projeyi klonlamak istediğiniz dizine gidin.

Open WebUI deposunu Git ile klonlayın:

git clone https://github.com/open-webui/open-webui.gitProje dizinine geçin:

cd open-webui.env dosyasını kopyalayın:

copy .env.example .envFrontend'i Node.js ile derleyin:

npm installnpm run buildbackend dizinine geçin:

cd .\backend(İsteğe bağlı) Bir Conda ortamı oluşturun ve etkinleştirin:

conda create --name open-webui-env python=3.11conda activate open-webui-envPython bağımlılıklarını yükleyin:

pip install -r requirements.txt -UUygulamayı başlatın:

start_windows.batBu kılavuzu izleyerek, Ollama ve Open WebUI'ı (Docker olmadan) yerel olarak herhangi bir sorun yaşamadan başarıyla çalıştırabilmelisiniz. Ancak, herhangi bir hata veya zorlukla karşılaşırsanız, bir yorum bırakmaktan çekinmeyin, size yardımcı olmak için elimden geleni yapacağım.

Ollama + Open WebUI: LLM'leri Windows, Linux veya macOS'ta (Docker'sız) Yerel Olarak Çalıştırmanın Bir Yolu