2024-10-07

Timp estimat de citire: 5 minutes

Acest ghid vă va arăta cum să configurați și să rulați cu ușurință modelele lingvistice mari (LLM-uri) local, folosind Ollama și Open WebUI pe Windows, Linux sau macOS - fără a fi nevoie de Docker. Ollama oferă inferență locală a modelului, iar Open WebUI este o interfață de utilizator care simplifică interacțiunea cu aceste modele. Experiența este similară cu utilizarea interfețelor precum ChatGPT, Google Gemini sau Claude AI.

Rularea Open WebUI fără Docker vă permite să utilizați resursele computerului dvs. mai eficient. Fără limitările mediilor containerizate, toată memoria sistemului disponibilă, puterea CPU și spațiul de stocare pot fi dedicate în totalitate rulării aplicației. Acest lucru este deosebit de important atunci când lucrați cu modele care consumă multe resurse, unde fiecare performanță contează.

De exemplu, dacă utilizați Open WebUI pentru a interacționa cu modele lingvistice mari, rularea nativă poate duce la timpi de procesare mai rapizi și la o performanță mai fluidă, deoarece nu există nicio supraîncărcare din gestionarea containerului Docker. Rulând nativ, obțineți și:

Înainte de a începe, asigurați-vă că aveți următoarele instalate pe sistemul dvs.:

Asigurați-vă că utilizați Python 3.11.X. De exemplu, versiunea 3.11.6 funcționează bine. Ultima versiune de Python, 3.12.7, nu este compatibilă cu versiunea actuală a Open WebUI.

Puteți descărca Python aici. Asigurați-vă că selectați versiunea corespunzătoare pentru sistemul dvs. de operare. Python este un limbaj de programare versatil, utilizat pe scară largă în AI și învățare automată, inclusiv pentru dezvoltarea și funcționarea modelelor lingvistice mari (LLM-uri). Dacă doriți să vă dezvoltați abilitățile în acest domeniu, nu uitați să consultați fișele de învățare Python pentru o modalitate rapidă și eficientă de a învăța.

Pentru a instala Open WebUI, puteți utiliza managerul de pachete pip al Python. Urmați acești pași:

Deschideți terminalul și rulați următoarea comandă pentru a instala Open WebUI:

pip install open-webuiDupă instalare, actualizați pip la cea mai recentă versiune rulând:

python.exe -m pip install --upgrade pipOdată ce Open WebUI este instalat, porniți serverul folosind următoarea comandă:

open-webui serveDupă ce Open WebUI a fost pornit cu succes, îl puteți accesa în browserul dvs. la: http://localhost:8080.

De asemenea, dacă preferați, puteți instala Open WebUI clonând proiectul direct de pe GitHub. Pentru mai multe detalii, consultați secțiunea de la sfârșitul acestui ghid.

În mod implicit, Ollama setează următoarele căi pentru stocarea modelelor lingvistice (LLM-uri) pe sistemul dvs.:

~/.ollama/models/usr/share/ollama/.ollama/modelsC:\Users\%username%\.ollama\modelsPuteți schimba această cale dacă este necesar. De exemplu, pe Windows, utilizați următoarea comandă:

setx OLLAMA_MODELS "D:\ollama_models"Dacă rulați Ollama ca aplicație macOS, variabilele de mediu trebuie setate utilizând launchctl. Pentru a seta o variabilă, utilizați următoarea comandă:

launchctl setenv OLLAMA_MODELS "/new/path/to/models"După setarea variabilei, reporniți aplicația Ollama pentru ca modificările să aibă efect.

Pentru utilizatorii Linux care rulează Ollama ca serviciu systemd, puteți seta variabilele de mediu utilizând systemctl. Iată cum să faceți acest lucru:

Deschideți configurația serviciului rulând:

sudo systemctl edit ollama.serviceSub secțiunea [Service], adăugați următoarea linie:

Environment="OLLAMA_MODELS=/new/path/to/models"Salvați fișierul, apoi reîncărcați systemd și reporniți serviciul:

sudo systemctl daemon-reloadsudo systemctl restart ollamaPentru a descărca și rula modele lingvistice în Ollama, utilizați următoarele comenzi în terminal. Aceste comenzi vor descărca automat modelul dacă nu este deja instalat:

Pentru a descărca și rula modelul LLaMA 3.1 de la Meta (Facebook):

ollama run llama3.1Pentru a descărca și rula modelul Gemma 2 de la Google:

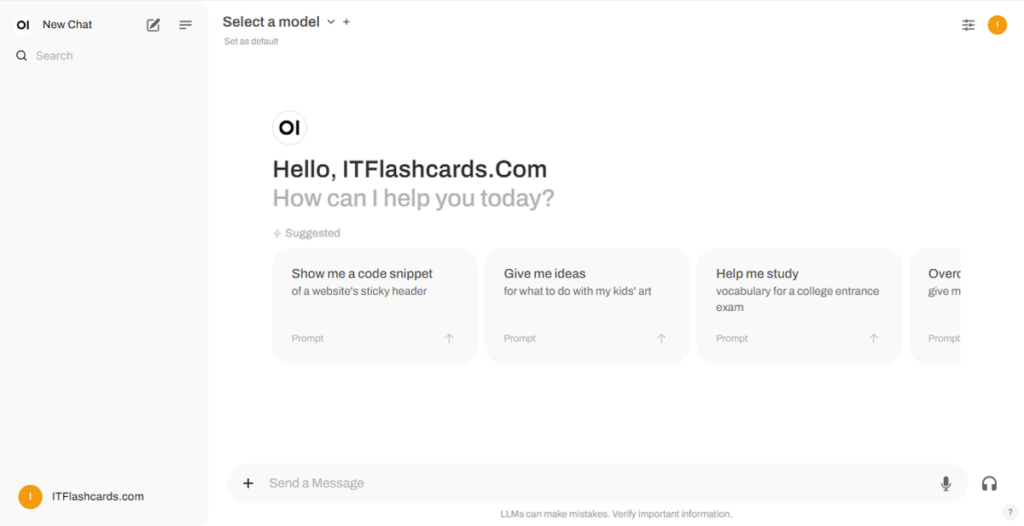

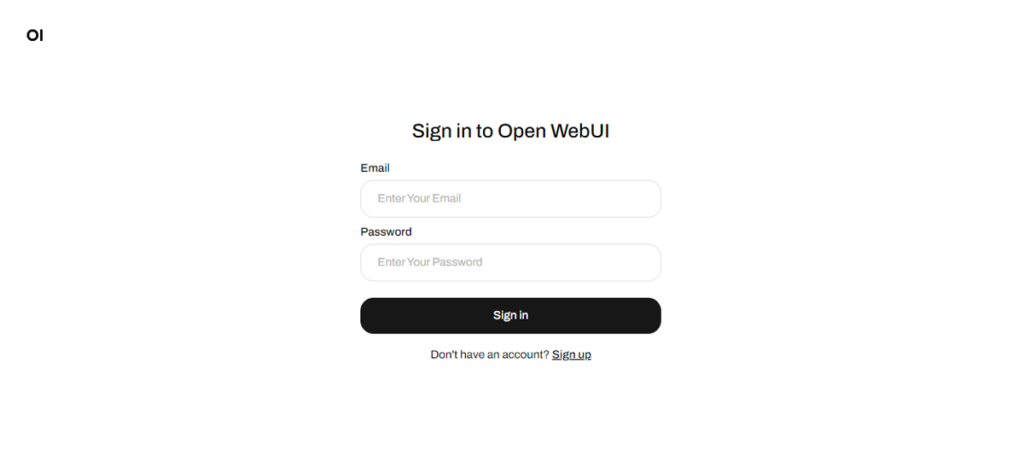

ollama run gemma2Odată ce Open WebUI este pornit, îl puteți accesa la http://localhost:8080. După ce navigați la această adresă, vi se va cere să vă autentificați sau să vă înregistrați. Pentru a crea un cont nou, selectați opțiunea Sign Up. Acest cont este creat local, ceea ce înseamnă că este disponibil doar pe acest dispozitiv și niciun alt utilizator din sistemul dvs. nu va avea acces la datele dvs.

Dacă ați pornit anterior Open WebUI și modelele descărcate prin Ollama nu apar în listă, reîmprospătați pagina pentru a actualiza modelele disponibile. Toate datele gestionate în Open WebUI sunt stocate local pe dispozitivul dvs., asigurându-vă confidențialitatea și controlul asupra modelelor și interacțiunilor dvs.

Dacă doriți să instalați Open WebUI clonând proiectul de pe GitHub și gestionându-l manual, urmați acești pași:

Deschideți un terminal și navigați la directorul în care doriți să clonați depozitul.

Clonați depozitul Open WebUI folosind Git:

git clone https://github.com/open-webui/open-webui.gitSchimbați în directorul proiectului:

cd open-webui/Copiați fișierul .env:

cp -RPp .env.example .envConstruiți frontend-ul folosind Node.js:

npm installnpm run buildIntrați în directorul backend:

cd ./backend(Opțional) Creați și activați un mediu Conda:

conda create --name open-webui-env python=3.11conda activate open-webui-envInstalați dependențele Python:

pip install -r requirements.txt -UPorniți aplicația:

bash start.shDeschideți un terminal și navigați la directorul în care doriți să clonați depozitul.

Clonați depozitul Open WebUI folosind Git:

git clone https://github.com/open-webui/open-webui.gitSchimbați în directorul proiectului:

cd open-webuiCopiați fișierul .env:

copy .env.example .envConstruiți frontend-ul folosind Node.js:

npm installnpm run buildIntrați în directorul backend:

cd .\backend(Opțional) Creați și activați un mediu Conda:

conda create --name open-webui-env python=3.11conda activate open-webui-envInstalați dependențele Python:

pip install -r requirements.txt -UPorniți aplicația:

start_windows.batUrmând acest ghid, ar trebui să puteți rula Ollama și Open WebUI (fără Docker) local cu succes, fără probleme. Cu toate acestea, dacă întâmpinați erori sau dificultăți pe parcurs, nu ezitați să lăsați un comentariu, iar eu voi face tot posibilul să vă ajut.

Ollama + Open WebUI: O metodă de a rula LLM-uri local pe Windows, Linux sau macOS (fără Docker)