Ollama + Open WebUI: Een manier om LLM’s lokaal uit te voeren op Windows, Linux of macOS (zonder Docker)

Estimated reading time: 6 minuten

Inleiding

Deze gids laat zien hoe je eenvoudig grote taalmodellen (LLMs) lokaal kunt instellen en gebruiken met Ollama en Open WebUI op Windows, Linux of macOS – zonder dat Docker nodig is. Ollama biedt lokale modelinference, en Open WebUI is een gebruikersinterface die het interactieproces met deze modellen vereenvoudigt. De ervaring lijkt op die van interfaces zoals ChatGPT, Google Gemini of Claude AI.

Waarom Open WebUI zonder Docker uitvoeren?

Het uitvoeren van Open WebUI zonder Docker stelt je in staat de bronnen van je computer efficiënter te benutten. Zonder de beperkingen van containeromgevingen kan alle beschikbare systeemgeheugen, CPU-kracht en opslag volledig worden gebruikt voor het uitvoeren van de applicatie. Dit is vooral belangrijk bij het werken met modellen die veel middelen vereisen, waar elke prestatieverbetering telt.

Bijvoorbeeld, als je Open WebUI gebruikt om met grote taalmodellen te werken, kan native uitvoering resulteren in snellere verwerkingstijden en soepelere prestaties, aangezien er geen overhead is van Docker die de container beheert. Door native te werken, krijg je ook:

- Eenvoudigere installatie: Je vermijdt de complexiteit van het opzetten en beheren van Docker-containers, wat vooral handig kan zijn voor gebruikers die de voorkeur geven aan een directe en eenvoudige installatie.

- Verbeterde prestaties: Zonder de virtualisatie van Docker is er een directere verbinding met de systeembronnen, wat kan leiden tot betere applicatieprestaties.

- Directe toegang tot systeembronnen: Je hebt directe controle over bestandslocaties, instellingen en systeemconfiguraties, wat het oplossen van problemen en het aanpassen eenvoudiger maakt.

Vereisten

Voordat je begint, zorg ervoor dat je het volgende op je systeem hebt geïnstalleerd:

- Python: Vereist om Open WebUI uit te voeren.

Zorg ervoor dat je Python 3.11.X gebruikt. Versie 3.11.6 werkt bijvoorbeeld goed. De nieuwste versie van Python, 3.12.7, is niet compatibel met de huidige versie van Open WebUI.

Je kunt Python downloaden hier. Zorg ervoor dat je de juiste versie kiest voor je besturingssysteem. Python is een veelzijdige programmeertaal die veel wordt gebruikt in AI en machine learning, waaronder de ontwikkeling en werking van grote taalmodellen (LLMs). Als je je vaardigheden op dit gebied wilt verbeteren, bekijk dan onze python flashcards voor een snelle en efficiënte manier om te leren.

Ollama installeren

- Ga naar de Ollama downloadpagina.

- Kies je platform (Windows, Linux of macOS) en download de juiste versie.

- Installeer Ollama via het standaardinstallatieproces voor je platform.

Open WebUI installeren en uitvoeren

Om Open WebUI te installeren, kun je de pakketbeheerder pip van Python gebruiken. Volg deze stappen:

Open je terminal en voer de volgende opdracht uit om Open WebUI te installeren:

pip install open-webuiNa de installatie werk je pip bij naar de nieuwste versie door het volgende uit te voeren:

python.exe -m pip install --upgrade pipZodra Open WebUI is geïnstalleerd, start je de server met de volgende opdracht:

open-webui serveNa het succesvol starten van Open WebUI kun je het openen in je browser via: http://localhost:8080.

Bovendien kun je, als je dat liever hebt, Open WebUI installeren door het project rechtstreeks van GitHub te klonen. Zie het gedeelte aan het einde van deze gids voor meer details.

Ollama configureren en taalmodellen downloaden

Ollama gebruikt standaard de volgende paden om taalmodellen (LLMs) op je systeem op te slaan:

- macOS:

~/.ollama/models - Linux:

/usr/share/ollama/.ollama/models - Windows:

C:\Users\%username%\.ollama\models

Je kunt dit pad indien nodig wijzigen. Gebruik bijvoorbeeld op Windows de volgende opdracht:

setx OLLAMA_MODELS "D:\ollama_models"Omgevingsvariabelen instellen op macOS

Als je Ollama als macOS-toepassing gebruikt, moeten omgevingsvariabelen worden ingesteld met behulp van launchctl. Gebruik de volgende opdracht om een variabele in te stellen:

launchctl setenv OLLAMA_MODELS "/new/path/to/models"Na het instellen van de variabele, start je de Ollama-toepassing opnieuw om de wijzigingen door te voeren.

Omgevingsvariabelen instellen op Linux

Voor Linux-gebruikers die Ollama als een systemd-service uitvoeren, kun je omgevingsvariabelen instellen met systemctl. Hier is hoe je dit doet:

Open de serviceconfiguratie door het volgende uit te voeren:

sudo systemctl edit ollama.serviceVoeg onder de [Service]-sectie de volgende regel toe:

Environment="OLLAMA_MODELS=/new/path/to/models"Sla het bestand op, herlaad systemd en start de service opnieuw:

sudo systemctl daemon-reload sudo systemctl restart ollama

Taalmodellen downloaden en uitvoeren in Ollama

Gebruik de volgende opdrachten in de terminal om taalmodellen in Ollama te downloaden en uit te voeren. Deze opdrachten downloaden het model automatisch als het nog niet is geïnstalleerd:

Om het LLaMA 3.1-model van Meta (Facebook) te downloaden en uit te voeren:

ollama run llama3.1Om het Gemma 2-model van Google te downloaden en uit te voeren:

ollama run gemma2

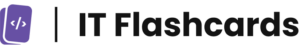

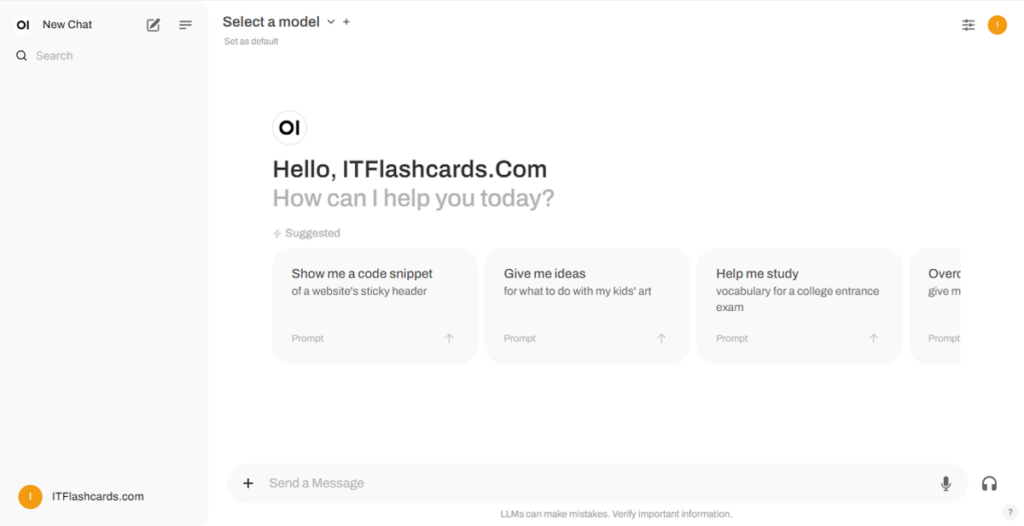

Open WebUI gebruiken

Zodra Open WebUI wordt uitgevoerd, kun je deze openen via http://localhost:8080. Nadat je naar dit adres bent genavigeerd, wordt je gevraagd om in te loggen of te registreren. Kies de optie “Aanmelden” om een nieuw account aan te maken. Dit account wordt lokaal aangemaakt, wat betekent dat het alleen beschikbaar is op deze machine en geen andere gebruiker op je systeem toegang heeft tot je gegevens.

Als je eerder Open WebUI hebt gestart en de via Ollama gedownloade modellen niet op de lijst verschijnen, vernieuw dan de pagina om de beschikbare modellen bij te werken. Alle gegevens die binnen Open WebUI worden beheerd, worden lokaal op je apparaat opgeslagen, wat privacy en controle over je modellen en interacties garandeert.

Open WebUI installeren met Git

Als je Open WebUI wilt installeren door het project van GitHub te klonen en handmatig te beheren, volg dan deze stappen:

Vereisten:

- Git: Zorg ervoor dat Git op je systeem is geïnstalleerd. Je kunt het hier downloaden.

- Anaconda: Het wordt aanbevolen om Anaconda te gebruiken om je Python-omgeving te beheren. Je kunt Anaconda downloaden en installeren via deze link.

Installatie-instructies:

Voor Linux/macOS:

Open een terminal en navigeer naar de map waar je de repository wilt klonen.

Kloon de Open WebUI-repository met Git:

git clone https://github.com/open-webui/open-webui.gitGa naar de projectmap:

cd open-webui/Kopieer het .env-bestand:

cp -RPp .env.example .envBouw de frontend met Node.js:

npm install npm run buildGa naar de

backend-map:cd ./backend(Optioneel) Maak en activeer een Conda-omgeving:

conda create --name open-webui-env python=3.11 conda activate open-webui-envInstalleer de Python-afhankelijkheden:

pip install -r requirements.txt -UStart de applicatie:

bash start.sh

Voor Windows:

Open een terminal en navigeer naar de map waar je de repository wilt klonen.

Kloon de Open WebUI-repository met Git:

git clone https://github.com/open-webui/open-webui.gitGa naar de projectmap:

cd open-webuiKopieer het .env-bestand:

copy .env.example .envBouw de frontend met Node.js:

npm install npm run buildGa naar de backend-map:

cd .\backend(Optioneel) Maak en activeer een Conda-omgeving:

conda create --name open-webui-env python=3.11 conda activate open-webui-envInstalleer de Python-afhankelijkheden:

pip install -r requirements.txt -UStart de applicatie:

start_windows.bat

Ollama + Open WebUI Samenvatting

Door deze gids te volgen, zou je zonder problemen Ollama en Open WebUI (zonder Docker) lokaal moeten kunnen uitvoeren. Mocht je onderweg fouten of moeilijkheden tegenkomen, laat dan een reactie achter, en ik zal mijn best doen om je te helpen.