작성자 Szymon Bodych

2024-10-07

추정 소요 시간: 4 minutes

이 가이드는 Docker 없이 Windows, Linux 또는 macOS에서 Ollama와 Open WebUI를 사용하여 대형 언어 모델(LLM)을 로컬에서 쉽게 설정하고 실행하는 방법을 안내합니다. Ollama는 로컬 모델 추론을 제공하며, Open WebUI는 이러한 모델과의 상호작용을 간소화하는 사용자 인터페이스입니다. 이 경험은 ChatGPT, Google Gemini 또는 Claude AI와 유사합니다.

Docker 없이 Open WebUI를 실행하면 컴퓨터의 리소스를 더 효율적으로 사용할 수 있습니다. 컨테이너화된 환경의 제한이 없으므로 사용 가능한 모든 시스템 메모리, CPU 성능 및 저장 공간이 애플리케이션 실행에 전적으로 사용될 수 있습니다. 이는 리소스를 많이 사용하는 모델을 작업할 때 특히 중요합니다.

예를 들어, 대형 언어 모델과 상호작용하기 위해 Open WebUI를 사용할 때, Docker가 컨테이너를 관리하는 오버헤드가 없기 때문에 네이티브 실행으로 더 빠른 처리 시간과 원활한 성능을 얻을 수 있습니다. 네이티브 실행을 통해 다음과 같은 이점도 얻을 수 있습니다:

시작하기 전에 시스템에 다음이 설치되어 있는지 확인하십시오:

Python 3.11.X를 사용하고 있는지 확인하십시오. 예를 들어, 3.11.6 버전이 잘 작동합니다. 최신 버전인 3.12.7은 현재 Open WebUI 버전과 호환되지 않습니다.

여기에서 Python을 다운로드할 수 있습니다. 운영 체제에 맞는 적절한 버전을 선택하십시오. Python은 AI 및 기계 학습에서 널리 사용되는 다재다능한 프로그래밍 언어이며, 대형 언어 모델(LLM)의 개발 및 운영에 사용됩니다. 이 분야에서 기술을 향상시키고자 한다면, 저희 python flashcards를 확인하여 빠르고 효율적인 학습을 진행해보세요.

Open WebUI를 설치하려면 Python의 패키지 관리자 pip를 사용할 수 있습니다. 다음 단계를 따르십시오:

터미널을 열고 다음 명령을 실행하여 Open WebUI를 설치하십시오:

pip install open-webui설치 후, 다음 명령을 실행하여 pip를 최신 버전으로 업데이트하십시오:

python.exe -m pip install --upgrade pipOpen WebUI가 설치되면 다음 명령을 사용하여 서버를 시작하십시오:

open-webui serveOpen WebUI가 성공적으로 시작된 후, 브라우저에서 다음 주소로 접속할 수 있습니다: http://localhost:8080.

또한, GitHub에서 프로젝트를 직접 클론하여 Open WebUI를 설치할 수도 있습니다. 자세한 내용은 이 가이드의 마지막 섹션을 참조하십시오.

기본적으로 Ollama는 시스템에서 언어 모델(LLM)을 저장하는 경로를 다음과 같이 설정합니다:

~/.ollama/models/usr/share/ollama/.ollama/modelsC:\Users\%username%\.ollama\models필요한 경우 이 경로를 변경할 수 있습니다. 예를 들어, Windows에서 다음 명령을 사용하십시오:

setx OLLAMA_MODELS "D:\ollama_models"macOS 애플리케이션으로 Ollama를 실행하는 경우, 환경 변수는 launchctl을 사용하여 설정해야 합니다. 변수를 설정하려면 다음 명령을 사용하십시오:

launchctl setenv OLLAMA_MODELS "/new/path/to/models"변수를 설정한 후, Ollama 애플리케이션을 다시 시작하여 변경 사항을 적용하십시오.

Linux에서 Ollama를 systemd 서비스로 실행하는 경우, systemctl을 사용하여 환경 변수를 설정할 수 있습니다. 다음 방법을 따르십시오:

다음 명령을 실행하여 서비스 구성을 엽니다:

sudo systemctl edit ollama.service[Service] 섹션 아래에 다음 줄을 추가하십시오:

Environment="OLLAMA_MODELS=/new/path/to/models"파일을 저장한 후, systemd를 다시 로드하고 서비스를 다시 시작하십시오:

sudo systemctl daemon-reloadsudo systemctl restart ollamaOllama에서 언어 모델을 다운로드하고 실행하려면 터미널에서 다음 명령을 사용하십시오. 이 명령들은 모델이 설치되어 있지 않은 경우 자동으로 다운로드됩니다:

Meta(페이스북)의 LLaMA 3.1 모델을 다운로드하고 실행하려면:

ollama run llama3.1Google의 Gemma 2 모델을 다운로드하고 실행하려면:

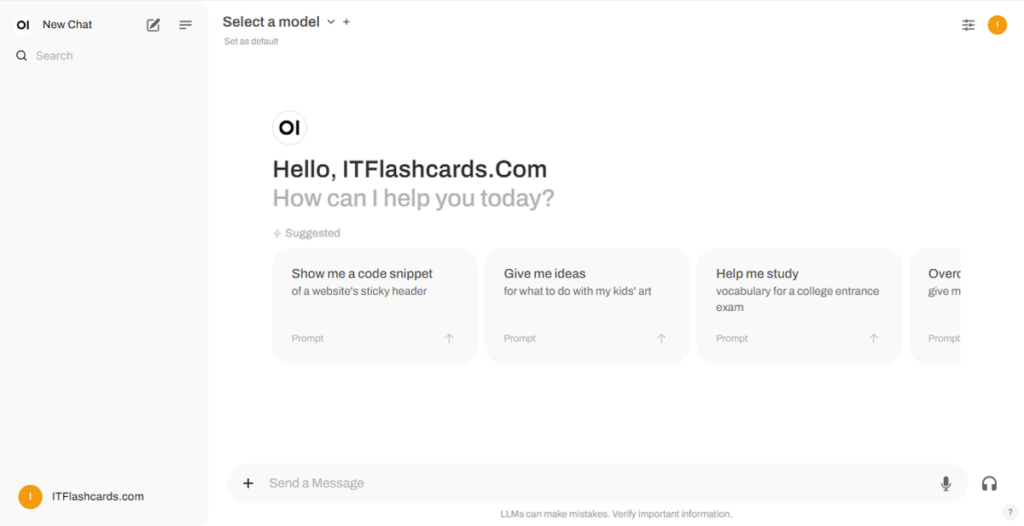

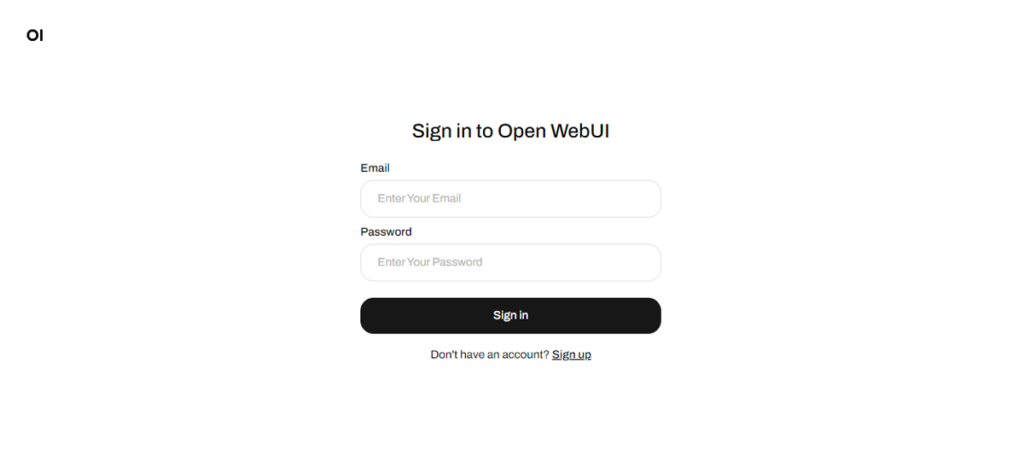

ollama run gemma2Open WebUI가 실행되면 http://localhost:8080에서 액세스할 수 있습니다. 이 주소로 이동하면 로그인 또는 등록하라는 메시지가 표시됩니다. 새 계정을 만들려면 가입 옵션을 선택하십시오. 이 계정은 로컬로 생성되며, 이 기기에서만 사용할 수 있으며 다른 사용자는 데이터에 액세스할 수 없습니다.

이전에 Open WebUI를 시작했는데 Ollama를 통해 다운로드한 모델이 목록에 표시되지 않는 경우, 페이지를 새로 고쳐 사용 가능한 모델을 업데이트하십시오. Open WebUI에서 관리되는 모든 데이터는 기기 내에 로컬로 저장되며, 데이터 및 상호작용에 대한 개인 정보와 제어 권한을 보장합니다.

GitHub에서 프로젝트를 클론하고 수동으로 관리하여 Open WebUI를 설치하려면 다음 단계를 따르십시오:

터미널을 열고 클론하려는 디렉터리로 이동하십시오.

Git을 사용하여 Open WebUI 리포지토리를 클론하십시오:

git clone https://github.com/open-webui/open-webui.git프로젝트 디렉터리로 이동하십시오:

cd open-webui/.env 파일을 복사하십시오:

cp -RPp .env.example .envNode.js를 사용하여 프런트엔드를 빌드하십시오:

npm installnpm run buildbackend 디렉터리로 이동하십시오:

cd ./backend(선택 사항) Conda 환경을 만들고 활성화하십시오:

conda create --name open-webui-env python=3.11conda activate open-webui-envPython 종속성을 설치하십시오:

pip install -r requirements.txt -U애플리케이션을 시작하십시오:

bash start.sh터미널을 열고 클론하려는 디렉터리로 이동하십시오.

Git을 사용하여 Open WebUI 리포지토리를 클론하십시오:

git clone https://github.com/open-webui/open-webui.git프로젝트 디렉터리로 이동하십시오:

cd open-webui.env 파일을 복사하십시오:

copy .env.example .envNode.js를 사용하여 프런트엔드를 빌드하십시오:

npm installnpm run build백엔드 디렉터리로 이동하십시오:

cd .\backend(선택 사항) Conda 환경을 만들고 활성화하십시오:

conda create --name open-webui-env python=3.11conda activate open-webui-envPython 종속성을 설치하십시오:

pip install -r requirements.txt -U애플리케이션을 시작하십시오:

start_windows.bat이 가이드를 따르면 Docker 없이 Ollama와 Open WebUI를 로컬에서 성공적으로 실행할 수 있습니다. 그러나 실행 중 오류가 발생하거나 문제가 있는 경우, 댓글을 남기시면 최대한 도움을 드리겠습니다.

Ollama + Open WebUI: Windows, Linux 또는 macOS에서 LLM을 로컬로 실행하는 방법 (Docker 없이)