द्वारा Szymon Bodych

2024-10-08

अनुमानित पढ़ने का समय: 7 minutes

यह मार्गदर्शिका आपको Windows, Linux, या macOS पर Docker की आवश्यकता के बिना Ollama और Open WebUI का उपयोग करके बड़े भाषा मॉडल (LLM) को आसानी से सेटअप और स्थानीय रूप से चलाने का तरीका दिखाएगी। Ollama स्थानीय मॉडल इन्फेरेंस प्रदान करता है, और Open WebUI एक उपयोगकर्ता इंटरफ़ेस है जो इन मॉडलों के साथ इंटरैक्शन को सरल बनाता है। यह अनुभव ChatGPT, Google Gemini, या Claude AI जैसे इंटरफेस के उपयोग के समान है।

Docker के बिना Open WebUI चलाने से आप अपने कंप्यूटर के संसाधनों का अधिक कुशलता से उपयोग कर सकते हैं। कंटेनरीकृत वातावरण की सीमाओं के बिना, उपलब्ध सभी सिस्टम मेमोरी, CPU पावर और स्टोरेज को पूरी तरह से एप्लिकेशन चलाने के लिए समर्पित किया जा सकता है। यह विशेष रूप से तब महत्वपूर्ण होता है जब आप संसाधन-गहन मॉडलों के साथ काम कर रहे होते हैं, जहां हर प्रदर्शन बिंदु मायने रखता है।

उदाहरण के लिए, मान लें कि आप बड़े भाषा मॉडलों के साथ इंटरैक्ट करने के लिए Open WebUI का उपयोग कर रहे हैं। इस मामले में, देशी निष्पादन तेज़ प्रोसेसिंग समय और सुचारू प्रदर्शन का परिणाम हो सकता है, क्योंकि Docker कंटेनर के प्रबंधन से कोई ओवरहेड नहीं होता है। देशी रूप से चलाने से आपको अतिरिक्त लाभ भी मिलते हैं:

शुरू करने से पहले, सुनिश्चित करें कि आपके सिस्टम पर निम्नलिखित इंस्टॉल हैं:

सुनिश्चित करें कि आप Python 3.11.X का उपयोग कर रहे हैं। उदाहरण के लिए, 3.11.6 संस्करण अच्छी तरह से काम करता है। Python का नवीनतम संस्करण, 3.12.7, वर्तमान संस्करण के साथ संगत नहीं है।

आप Python को यहाँ से डाउनलोड कर सकते हैं। अपने ऑपरेटिंग सिस्टम के लिए उपयुक्त संस्करण चुनना सुनिश्चित करें। Python एक बहुमुखी प्रोग्रामिंग भाषा है जिसका व्यापक रूप से AI और मशीन लर्निंग में उपयोग किया जाता है, जिसमें बड़े भाषा मॉडल (LLMs) का विकास और संचालन शामिल है। यदि आप इस क्षेत्र में अपने कौशल को बढ़ाना चाहते हैं, तो हमारे python फ्लैशकार्ड को एक त्वरित और कुशल तरीका देखें।

Open WebUI इंस्टॉल करने के लिए, आप Python के पैकेज प्रबंधक pip का उपयोग कर सकते हैं। इन चरणों का पालन करें:

अपने टर्मिनल को खोलें और Open WebUI को इंस्टॉल करने के लिए निम्नलिखित कमांड चलाएँ:

pip install open-webuiस्थापना के बाद, pip को नवीनतम संस्करण में अपडेट करने के लिए निम्नलिखित कमांड चलाएँ:

python.exe -m pip install --upgrade pipOpen WebUI इंस्टॉल हो जाने के बाद, सर्वर को चलाने के लिए निम्नलिखित कमांड का उपयोग करें:

open-webui serveOpen WebUI को सफलतापूर्वक शुरू करने के बाद, आप इसे अपने ब्राउज़र में इस URL पर एक्सेस कर सकते हैं: http://localhost:8080।

इसके अलावा, यदि आप चाहें तो सीधे GitHub से प्रोजेक्ट को क्लोन करके Open WebUI को इंस्टॉल कर सकते हैं। अधिक विवरण के लिए इस मार्गदर्शिका के अंत में देखें।

डिफ़ॉल्ट रूप से, Ollama आपके सिस्टम पर भाषा मॉडलों (LLMs) को संग्रहीत करने के लिए निम्नलिखित पथ सेट करता है:

~/.ollama/models/usr/share/ollama/.ollama/modelsC:\Users\%username%\.ollama\modelsआप इस पथ को आवश्यकता अनुसार बदल सकते हैं। उदाहरण के लिए, Windows पर निम्नलिखित कमांड का उपयोग करें:

setx OLLAMA_MODELS "D:\ollama_models"यदि आप Ollama को macOS एप्लिकेशन के रूप में चला रहे हैं, तो पर्यावरण चर को launchctl का उपयोग करके सेट किया जाना चाहिए। चर सेट करने के लिए, निम्नलिखित कमांड का उपयोग करें:

launchctl setenv OLLAMA_MODELS "/new/path/to/models"चर सेट करने के बाद, Ollama एप्लिकेशन को पुनरारंभ करें ताकि बदलाव प्रभावी हो सकें।

Linux उपयोगकर्ताओं के लिए जो Ollama को systemd सेवा के रूप में चला रहे हैं, आप systemctl का उपयोग करके पर्यावरण चर सेट कर सकते हैं। यहाँ इसे करने का तरीका है:

सेवा कॉन्फ़िगरेशन को खोलने के लिए निम्नलिखित कमांड चलाएँ:

sudo systemctl edit ollama.service[Service] अनुभाग के तहत, निम्नलिखित पंक्ति जोड़ें:

Environment="OLLAMA_MODELS=/new/path/to/models"फ़ाइल को सहेजें, फिर systemd को पुनः लोड करें और सेवा को पुनरारंभ करें:

sudo systemctl daemon-reloadsudo systemctl restart ollamaOllama में भाषा मॉडल डाउनलोड और चलाने के लिए, टर्मिनल में निम्नलिखित कमांड का उपयोग करें। यदि मॉडल पहले से इंस्टॉल नहीं है, तो ये कमांड स्वचालित रूप से मॉडल को डाउनलोड कर लेंगी:

Meta (Facebook) से LLaMA 3.1 मॉडल डाउनलोड और चलाने के लिए:

ollama run llama3.1Google से Gemma 2 मॉडल डाउनलोड और चलाने के लिए:

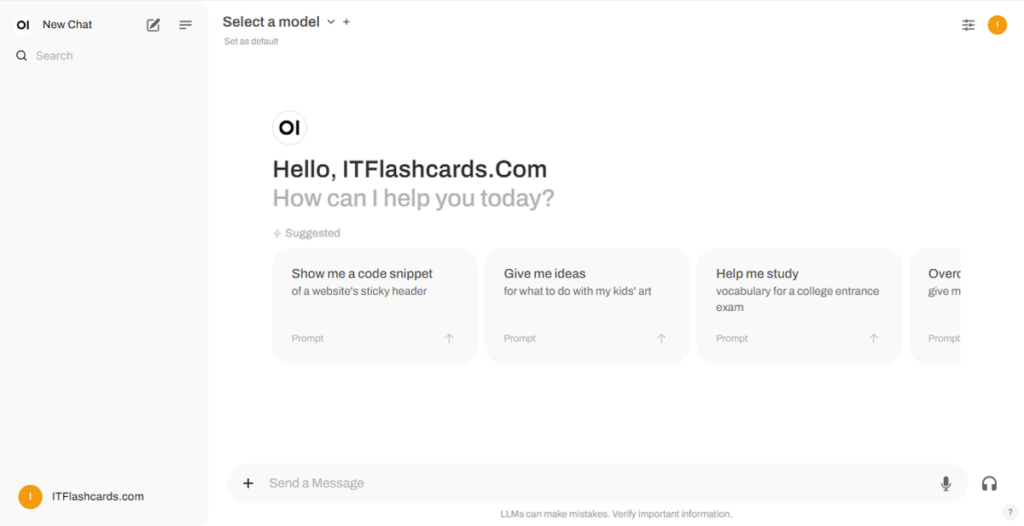

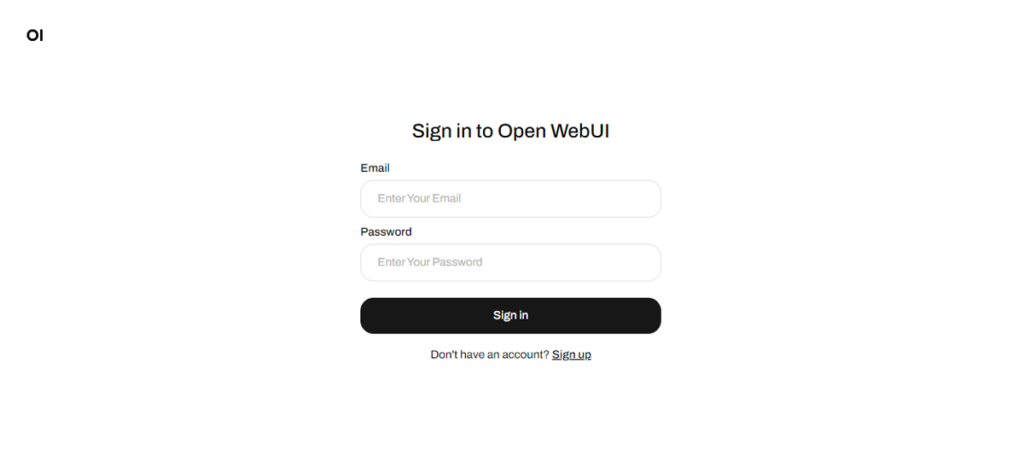

ollama run gemma2Open WebUI चलने के बाद, आप इसे http://localhost:8080 के माध्यम से एक्सेस कर सकते हैं। इस पते पर जाने के बाद, आपको लॉगिन या रजिस्टर करने के लिए प्रेरित किया जाएगा। एक नया खाता बनाने के लिए, साइन अप विकल्प चुनें। यह खाता स्थानीय रूप से बनाया जाता है, जिसका अर्थ है कि यह केवल इस मशीन पर उपलब्ध है, और आपके सिस्टम पर अन्य उपयोगकर्ताओं को आपके डेटा तक पहुंच नहीं होगी।

यदि आपने पहले Open WebUI शुरू किया है और Ollama के माध्यम से डाउनलोड किए गए मॉडल सूची में दिखाई नहीं दे रहे हैं, तो उपलब्ध मॉडलों को अपडेट करने के लिए पृष्ठ को रीफ़्रेश करें। Open WebUI के भीतर प्रबंधित सभी डेटा आपके डिवाइस पर स्थानीय रूप से संग्रहीत होते हैं, जो आपके मॉडलों और इंटरैक्शन पर गोपनीयता और नियंत्रण सुनिश्चित करते हैं।

यदि आप Open WebUI को GitHub से प्रोजेक्ट को क्लोन करके और मैन्युअल रूप से प्रबंधित करके इंस्टॉल करना चाहते हैं, तो इन चरणों का पालन करें:

एक टर्मिनल खोलें और उस निर्देशिका में नेविगेट करें जहाँ आप रिपॉजिटरी को क्लोन करना चाहते हैं।

Git का उपयोग करके Open WebUI रिपॉजिटरी को क्लोन करें:

git clone https://github.com/open-webui/open-webui.gitप्रोजेक्ट निर्देशिका में जाएँ:

cd open-webui/.env फ़ाइल को कॉपी करें:

cp -RPp .env.example .envNode.js का उपयोग करके फ्रंटएंड का निर्माण करें:

npm installnpm run buildbackend निर्देशिका में जाएँ:

cd ./backend(वैकल्पिक) एक Conda वातावरण बनाएं और सक्रिय करें:

conda create --name open-webui-env python=3.11conda activate open-webui-envPython निर्भरताओं को इंस्टॉल करें:

pip install -r requirements.txt -Uएप्लिकेशन को शुरू करें:

bash start.shएक टर्मिनल खोलें और उस निर्देशिका में नेविगेट करें जहाँ आप रिपॉजिटरी को क्लोन करना चाहते हैं।

Git का उपयोग करके Open WebUI रिपॉजिटरी को क्लोन करें:

git clone https://github.com/open-webui/open-webui.gitप्रोजेक्ट निर्देशिका में जाएँ:

cd open-webui.env फ़ाइल को कॉपी करें:

copy .env.example .envNode.js का उपयोग करके फ्रंटएंड का निर्माण करें:

npm installnpm run buildbackend निर्देशिका में जाएँ:

cd .\backend(वैकल्पिक) एक Conda वातावरण बनाएं और सक्रिय करें:

conda create --name open-webui-env python=3.11conda activate open-webui-envPython निर्भरताओं को इंस्टॉल करें:

pip install -r requirements.txt -Uएप्लिकेशन को शुरू करें:

start_windows.batइस मार्गदर्शिका का पालन करके, आपको बिना Docker के Ollama और Open WebUI को सफलतापूर्वक स्थानीय रूप से चलाने में सक्षम होना चाहिए। हालांकि, यदि आप किसी भी त्रुटियों या कठिनाइयों का सामना करते हैं, तो एक टिप्पणी छोड़ने में संकोच न करें, और मैं आपकी सहायता करने का सर्वोत्तम प्रयास करूंगा।

Ollama + Open WebUI: विंडोज, लिनक्स या macOS पर लोकली LLMs चलाने का एक तरीका (बिना Docker के)