Ollama + Open WebUI: Una forma de ejecutar LLMs localmente en Windows, Linux o macOS (sin Docker)

Tiempo estimado de lectura: 6 minutos

Introducción

Esta guía te mostrará cómo configurar y ejecutar fácilmente modelos de lenguaje grande (LLMs) localmente usando Ollama y Open WebUI en Windows, Linux o macOS, sin necesidad de Docker. Ollama proporciona inferencia de modelos local, y Open WebUI es una interfaz de usuario que simplifica la interacción con estos modelos. La experiencia es similar a usar interfaces como ChatGPT, Google Gemini o Claude AI.

¿Por qué ejecutar Open WebUI sin Docker?

Ejecutar Open WebUI sin Docker te permite utilizar los recursos de tu computadora de manera más eficiente. Sin las limitaciones de los entornos con contenedores, toda la memoria del sistema disponible, la potencia de la CPU y el almacenamiento pueden dedicarse completamente a ejecutar la aplicación. Esto es especialmente importante cuando se trabaja con modelos que requieren muchos recursos, donde cada porción de rendimiento es crucial.

Por ejemplo, si estás usando Open WebUI para interactuar con grandes modelos de lenguaje, la ejecución nativa puede resultar en tiempos de procesamiento más rápidos y un rendimiento más fluido, ya que no hay sobrecarga de Docker al gestionar el contenedor. Al ejecutar de manera nativa, también obtienes:

- Configuración más sencilla: Evitas la complejidad de configurar y gestionar contenedores Docker, lo que puede ser especialmente beneficioso para los usuarios que prefieren una instalación más simple y directa.

- Mejor rendimiento: Sin la virtualización de Docker, hay una conexión más directa con los recursos de tu sistema, lo que puede resultar en un mejor rendimiento de la aplicación.

- Acceso directo a los recursos del sistema: Tienes control directo sobre las rutas de archivos, configuraciones y ajustes del sistema, lo que facilita la resolución de problemas y la personalización.

Requisitos previos

Antes de comenzar, asegúrate de tener lo siguiente instalado en tu sistema:

- Python: Requerido para ejecutar Open WebUI.

Asegúrate de estar usando Python 3.11.X. Por ejemplo, la versión 3.11.6 funciona bien. La última versión de Python, 3.12.7, no es compatible con la versión actual de Open WebUI.

Puedes descargar Python aquí. Asegúrate de seleccionar la versión adecuada para tu sistema operativo. Python es un lenguaje de programación versátil ampliamente utilizado en inteligencia artificial y aprendizaje automático, incluyendo el desarrollo y operación de modelos de lenguaje grande (LLMs). Si deseas mejorar tus habilidades en esta área, no dudes en consultar nuestras tarjetas de aprendizaje de Python para un aprendizaje rápido y eficiente.

Instalación de Ollama

- Visita la página de descargas de Ollama.

- Elige tu plataforma (Windows, Linux o macOS) y descarga la versión correspondiente.

- Instala Ollama utilizando el proceso de instalación estándar para tu plataforma.

Instalación y ejecución de Open WebUI

Para instalar Open WebUI, puedes usar el gestor de paquetes pip de Python. Sigue estos pasos:

Abre tu terminal y ejecuta el siguiente comando para instalar Open WebUI:

pip install open-webuiDespués de la instalación, actualiza pip a la versión más reciente ejecutando:

python.exe -m pip install --upgrade pipUna vez que Open WebUI esté instalado, inicia el servidor usando el siguiente comando:

open-webui serveDespués de iniciar Open WebUI con éxito, puedes acceder a él en tu navegador en: http://localhost:8080.

Además, si lo prefieres, puedes instalar Open WebUI clonando el proyecto directamente desde GitHub. Para más detalles, consulta la sección al final de esta guía.

Configuración de Ollama y descarga de modelos de lenguaje

De manera predeterminada, Ollama establece las siguientes rutas para almacenar modelos de lenguaje (LLMs) en tu sistema:

- macOS:

~/.ollama/models - Linux:

/usr/share/ollama/.ollama/models - Windows:

C:\Users\%username%\.ollama\models

Puedes cambiar esta ruta si es necesario. Por ejemplo, en Windows, utiliza el siguiente comando:

setx OLLAMA_MODELS "D:\ollama_models"Configuración de variables de entorno en macOS

Si estás ejecutando Ollama como una aplicación de macOS, las variables de entorno deben configurarse usando launchctl. Para establecer una variable, usa el siguiente comando:

launchctl setenv OLLAMA_MODELS "/new/path/to/models"Después de configurar la variable, reinicia la aplicación Ollama para que los cambios surtan efecto.

Configuración de variables de entorno en Linux

Para los usuarios de Linux que ejecutan Ollama como un servicio systemd, puedes configurar las variables de entorno usando systemctl. Así es como se hace:

Abre la configuración del servicio ejecutando:

sudo systemctl edit ollama.serviceEn la sección [Service], agrega la siguiente línea:

Environment="OLLAMA_MODELS=/new/path/to/models"Guarda el archivo, luego recarga systemd y reinicia el servicio:

sudo systemctl daemon-reloadsudo systemctl restart ollama

Descarga y ejecución de modelos de lenguaje en Ollama

Para descargar y ejecutar modelos de lenguaje en Ollama, utiliza los siguientes comandos en el terminal. Estos comandos descargarán automáticamente el modelo si aún no está instalado:

Para descargar y ejecutar el modelo LLaMA 3.1 de Meta (Facebook):

ollama run llama3.1Para descargar y ejecutar el modelo Gemma 2 de Google:

ollama run gemma2

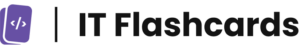

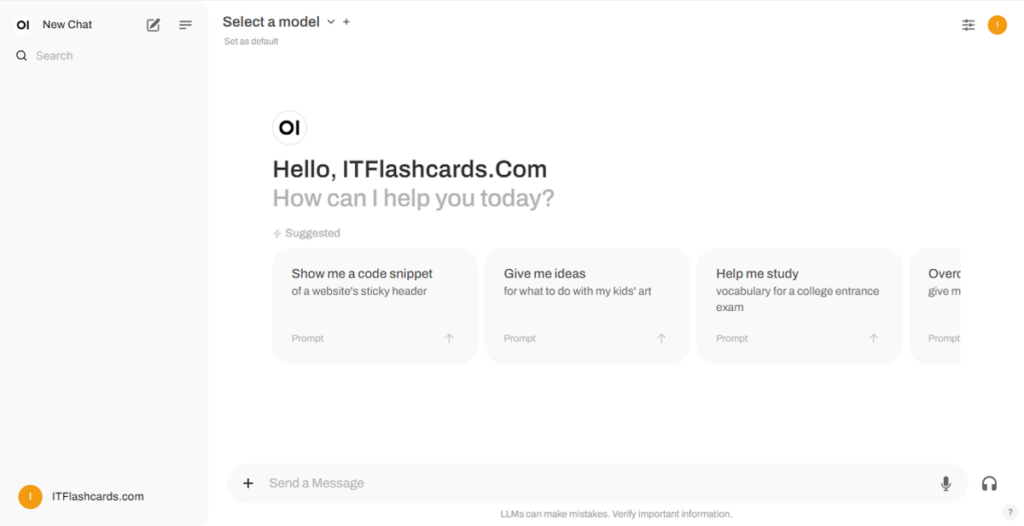

Uso de Open WebUI

Una vez que Open WebUI esté en funcionamiento, puedes acceder a él a través de http://localhost:8080. Después de navegar a esta dirección, se te pedirá que inicies sesión o te registres. Para crear una nueva cuenta, selecciona la opción Registrarse (Sign Up). Esta cuenta se crea localmente, lo que significa que solo está disponible en esta máquina y ningún otro usuario en tu sistema tendrá acceso a tus datos.

Si ya has iniciado Open WebUI anteriormente y los modelos descargados a través de Ollama no aparecen en la lista, actualiza la página para actualizar los modelos disponibles. Todos los datos gestionados dentro de Open WebUI se almacenan localmente en tu dispositivo, lo que garantiza la privacidad y el control sobre tus modelos e interacciones.

Instalación de Open WebUI usando Git

Si prefieres instalar Open WebUI clonando el proyecto desde GitHub y gestionándolo manualmente, sigue estos pasos:

Requisitos previos:

- Git: Asegúrate de tener Git instalado en tu sistema. Puedes descargarlo aquí.

- Anaconda: Se recomienda utilizar Anaconda para gestionar tu entorno Python. Puedes descargar e instalar Anaconda desde aquí.

Instrucciones de instalación:

Para Linux/macOS:

Abre un terminal y navega al directorio donde deseas clonar el repositorio.

Clona el repositorio Open WebUI usando Git:

git clone https://github.com/open-webui/open-webui.gitCambia al directorio del proyecto:

cd open-webui/Copia el archivo .env:

cp -RPp .env.example .envConstruye el frontend usando Node.js:

npm installnpm run buildCambia al directorio

backend:cd ./backend(Opcional) Crea y activa un entorno Conda:

conda create --name open-webui-env python=3.11conda activate open-webui-envInstala las dependencias de Python:

pip install -r requirements.txt -UInicia la aplicación:

bash start.sh

Para Windows:

Abre un terminal y navega al directorio donde deseas clonar el repositorio.

Clona el repositorio Open WebUI usando Git:

git clone https://github.com/open-webui/open-webui.gitCambia al directorio del proyecto:

cd open-webuiCopia el archivo .env:

copy .env.example .envConstruye el frontend usando Node.js:

npm installnpm run buildCambia al directorio backend:

cd .\backend(Opcional) Crea y activa un entorno Conda:

conda create --name open-webui-env python=3.11conda activate open-webui-envInstala las dependencias de Python:

pip install -r requirements.txt -UInicia la aplicación:

start_windows.bat

Resumen de Ollama + Open WebUI

Siguiendo esta guía, deberías poder ejecutar Ollama y Open WebUI (sin Docker) localmente sin problemas. Sin embargo, si encuentras algún error o dificultad en el camino, no dudes en dejar un comentario y haré lo mejor posible para asistirte.