von Szymon Bodych

2024-10-05

Geschätzte Lesezeit: 6 minutes

Diese Anleitung zeigt Ihnen, wie Sie große Sprachmodelle (LLMs) ganz einfach lokal mit Ollama und Open WebUI auf Windows, Linux oder macOS einrichten und ausführen können – ohne Docker. Ollama bietet die lokale Inferenz von Modellen, und Open WebUI ist eine Benutzeroberfläche, die die Interaktion mit diesen Modellen vereinfacht. Die Erfahrung ähnelt der Verwendung von Schnittstellen wie ChatGPT, Google Gemini oder Claude AI.

Das Ausführen von Open WebUI ohne Docker ermöglicht eine effizientere Nutzung der Ressourcen Ihres Computers. Ohne die Einschränkungen containerisierter Umgebungen können der gesamte verfügbare Arbeitsspeicher, die CPU-Leistung und der Speicherplatz vollständig der Ausführung der Anwendung gewidmet werden. Dies ist besonders wichtig bei der Arbeit mit ressourcenintensiven Modellen, bei denen jede Leistungssteigerung zählt.

Wenn Sie beispielsweise Open WebUI verwenden, um mit großen Sprachmodellen zu interagieren, kann die native Ausführung zu schnelleren Verarbeitungszeiten und einer reibungsloseren Leistung führen, da keine Docker-Überlastung zur Verwaltung des Containers besteht. Durch die native Ausführung erhalten Sie außerdem folgende Vorteile:

Bevor Sie beginnen, stellen Sie sicher, dass Folgendes auf Ihrem System installiert ist:

Stellen Sie sicher, dass Sie Python 3.11.X verwenden. Zum Beispiel funktioniert Version 3.11.6 gut. Die neueste Version von Python, 3.12.7, ist nicht mit der aktuellen Version von Open WebUI kompatibel.

Sie können Python hier herunterladen. Stellen Sie sicher, dass Sie die passende Version für Ihr Betriebssystem auswählen. Python ist eine vielseitige Programmiersprache, die weit verbreitet in den Bereichen KI und maschinelles Lernen verwendet wird, einschließlich der Entwicklung und des Betriebs großer Sprachmodelle (LLMs). Wenn Sie Ihre Fähigkeiten in diesem Bereich erweitern möchten, schauen Sie sich unsere Python-Karteikarten an, um schnell und effizient zu lernen.

Um Open WebUI zu installieren, können Sie den Paketmanager pip von Python verwenden. Befolgen Sie diese Schritte:

Öffnen Sie Ihr Terminal und führen Sie den folgenden Befehl aus, um Open WebUI zu installieren:

pip install open-webuiNach der Installation aktualisieren Sie pip auf die neueste Version, indem Sie den folgenden Befehl ausführen:

python.exe -m pip install --upgrade pipSobald Open WebUI installiert ist, starten Sie den Server mit folgendem Befehl:

open-webui serveNach dem erfolgreichen Start von Open WebUI können Sie über Ihren Browser darauf zugreifen unter: http://localhost:8080.

Alternativ können Sie Open WebUI auch installieren, indem Sie das Projekt direkt von GitHub klonen. Weitere Details finden Sie im Abschnitt am Ende dieses Leitfadens.

Standardmäßig legt Ollama die folgenden Pfade zum Speichern von Sprachmodellen (LLMs) auf Ihrem System fest:

~/.ollama/models/usr/share/ollama/.ollama/modelsC:\Users\%username%\.ollama\modelsSie können diesen Pfad bei Bedarf ändern. Verwenden Sie beispielsweise unter Windows den folgenden Befehl:

setx OLLAMA_MODELS "D:\ollama_models"Wenn Sie Ollama als macOS-Anwendung ausführen, sollten Umgebungsvariablen mit launchctl festgelegt werden. Um eine Variable festzulegen, verwenden Sie den folgenden Befehl:

launchctl setenv OLLAMA_MODELS "/new/path/to/models"Nachdem Sie die Variable festgelegt haben, starten Sie die Ollama-Anwendung neu, damit die Änderungen wirksam werden.

Für Linux-Benutzer, die Ollama als systemd-Dienst ausführen, können Umgebungsvariablen mit systemctl festgelegt werden. So geht's:

Öffnen Sie die Dienstkonfiguration, indem Sie den folgenden Befehl ausführen:

sudo systemctl edit ollama.serviceFügen Sie unter dem Abschnitt [Service] die folgende Zeile hinzu:

Environment="OLLAMA_MODELS=/new/path/to/models"Speichern Sie die Datei, laden Sie dann systemd neu und starten Sie den Dienst neu:

sudo systemctl daemon-reload

sudo systemctl restart ollamaUm Sprachmodelle in Ollama herunterzuladen und auszuführen, verwenden Sie die folgenden Befehle im Terminal. Diese Befehle laden das Modell automatisch herunter, wenn es noch nicht installiert ist:

Um das LLaMA 3.1-Modell von Meta (Facebook) herunterzuladen und auszuführen:

ollama run llama3.1Um das Gemma 2-Modell von Google herunterzuladen und auszuführen:

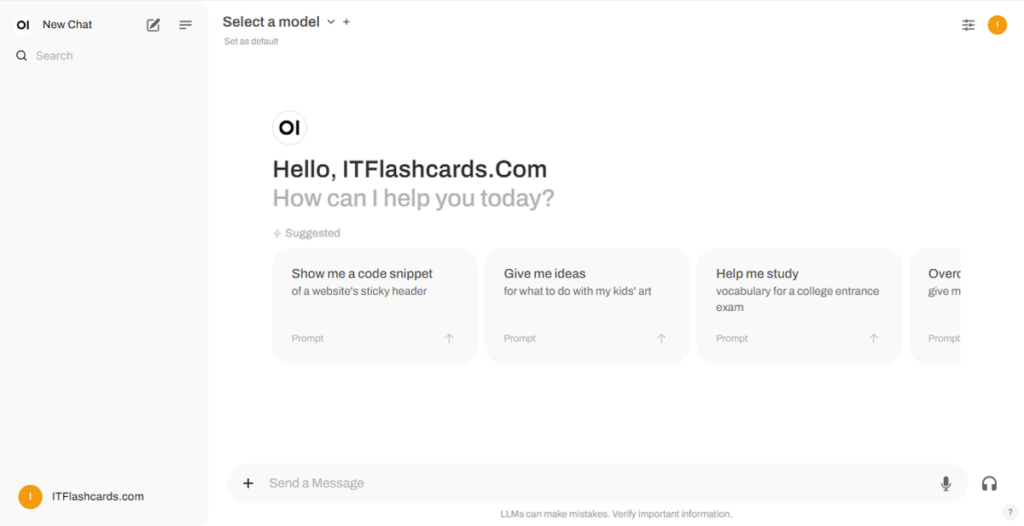

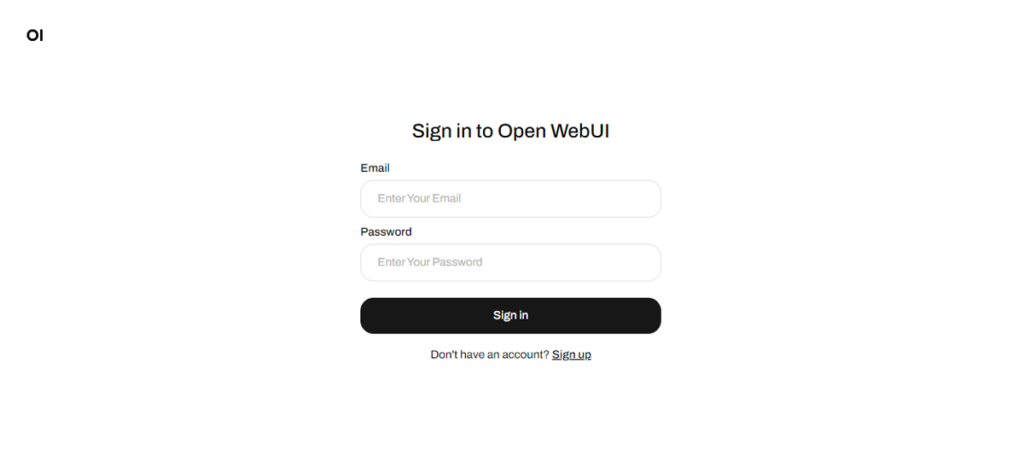

ollama run gemma2Sobald Open WebUI läuft, können Sie darauf über http://localhost:8080 zugreifen. Nachdem Sie diese Adresse aufgerufen haben, werden Sie aufgefordert, sich anzumelden oder zu registrieren. Um ein neues Konto zu erstellen, wählen Sie die Option Sign Up. Dieses Konto wird lokal erstellt, was bedeutet, dass es nur auf diesem Gerät verfügbar ist und kein anderer Benutzer in Ihrem System Zugriff auf Ihre Daten hat.

Wenn Sie Open WebUI bereits gestartet haben und die über Ollama heruntergeladenen Modelle nicht in der Liste erscheinen, aktualisieren Sie die Seite, um die verfügbaren Modelle zu aktualisieren. Alle Daten, die in Open WebUI verwaltet werden, werden lokal auf Ihrem Gerät gespeichert, was Privatsphäre und Kontrolle über Ihre Modelle und Interaktionen gewährleistet.

Wenn Sie Open WebUI installieren möchten, indem Sie das Projekt von GitHub klonen und es manuell verwalten, befolgen Sie diese Schritte:

Öffnen Sie ein Terminal und navigieren Sie zu dem Verzeichnis, in das Sie das Repository klonen möchten.

Klonen Sie das Open WebUI-Repository mit Git:

git clone https://github.com/open-webui/open-webui.gitWechseln Sie in das Projektverzeichnis:

cd open-webui/Kopieren Sie die .env-Datei:

cp -RPp .env.example .envErstellen Sie das Frontend mit Node.js:

npm install

npm run buildWechseln Sie in das Backend-Verzeichnis:

cd ./backend(Optional) Erstellen und aktivieren Sie eine Conda-Umgebung:

conda create --name open-webui-env python=3.11

conda activate open-webui-envInstallieren Sie die Python-Abhängigkeiten:

pip install -r requirements.txt -UStarten Sie die Anwendung:

bash start.shÖffnen Sie ein Terminal und navigieren Sie zu dem Verzeichnis, in das Sie das Repository klonen möchten.

Klonen Sie das Open WebUI-Repository mit Git:

git clone https://github.com/open-webui/open-webui.gitWechseln Sie in das Projektverzeichnis:

cd open-webuiKopieren Sie die .env-Datei:

copy .env.example .envBuild the frontend using Node.js:

npm install

npm run buildWechseln Sie in das Backend-Verzeichnis:

cd .\backend(Optional) Erstellen und aktivieren Sie eine Conda-Umgebung:

conda create --name open-webui-env python=3.11

conda activate open-webui-envInstallieren Sie die Python-Abhängigkeiten:

pip install -r requirements.txt -UStarten Sie die Anwendung:

start_windows.batWenn Sie dieser Anleitung folgen, sollten Sie in der Lage sein, Ollama und Open WebUI (ohne Docker) erfolgreich lokal auszuführen, ohne auf Probleme zu stoßen. Sollten Sie jedoch auf Fehler oder Schwierigkeiten stoßen, hinterlassen Sie gerne einen Kommentar, und ich werde mein Bestes tun, um Ihnen zu helfen.

Ollama + Open WebUI: Eine Möglichkeit, LLMs lokal auf Windows, Linux oder macOS (ohne Docker) auszuführen