Ollama + Open WebUI: Egy útmutató a helyi LLM futtatáshoz Windows, Linux vagy macOS rendszeren (Docker nélkül)

Becsült olvasási idő: 5 percek

Bevezetés

Ez az útmutató bemutatja, hogyan lehet könnyen beállítani és futtatni nagy nyelvi modelleket (LLM-eket) helyben, az Ollama és az Open WebUI használatával Windows, Linux vagy macOS rendszeren – Docker használata nélkül. Az Ollama helyi modellfeldolgozást biztosít, míg az Open WebUI egy felhasználói felület, amely egyszerűsíti a modellekkel való interakciót. Az élmény hasonló olyan felületekhez, mint a ChatGPT, a Google Gemini vagy a Claude AI.

Miért futtassuk az Open WebUI-t Docker nélkül?

Az Open WebUI Docker nélküli futtatása lehetővé teszi számítógépe erőforrásainak hatékonyabb kihasználását. A konténeres környezetek korlátai nélkül a rendelkezésre álló rendszermemória, CPU teljesítmény és tárhely teljes mértékben a program futtatására használható. Ez különösen fontos, amikor erőforrás-igényes modellekkel dolgozik, ahol minden teljesítménybeli előny számít.

Például, ha az Open WebUI-t nagy nyelvi modellek kezelésére használja, a natív futtatás gyorsabb feldolgozási időket és simább működést eredményezhet, mivel nincs a Docker által kezelt konténer többletterhelése. A natív futtatás további előnyei:

- Egyszerűbb beállítás: Elkerüli a Docker konténerek beállításának és kezelésének bonyolultságát, ami különösen előnyös lehet azok számára, akik egyszerűbb, közvetlen telepítést preferálnak.

- Jobb teljesítmény: A Docker virtualizációja nélkül közvetlenebb a kapcsolat a rendszer erőforrásaival, ami jobb programteljesítményt eredményezhet.

- Közvetlen hozzáférés a rendszer erőforrásaihoz: Közvetlenül kezelheti az elérési útvonalakat, beállításokat és rendszerkonfigurációkat, ami megkönnyíti a hibaelhárítást és a testreszabást.

Előfeltételek

Mielőtt elkezdené, győződjön meg róla, hogy az alábbiak telepítve vannak a rendszerén:

- Python: Szükséges az Open WebUI futtatásához.

Győződjön meg arról, hogy a Python 3.11.X verzióját használja. Például a 3.11.6 verzió jól működik. A Python legújabb, 3.12.7 verziója nem kompatibilis az Open WebUI jelenlegi verziójával.

A Python letölthető innen. Ügyeljen arra, hogy az operációs rendszerének megfelelő verziót válassza. A Python egy sokoldalú programozási nyelv, amelyet széles körben használnak mesterséges intelligenciában és gépi tanulásban, beleértve a nagy nyelvi modellek (LLM-ek) fejlesztését és működtetését. Ha bővíteni szeretné ismereteit ezen a területen, nézze meg Python kártyák, amelyekkel gyorsan és hatékonyan tanulhat.

Az Ollama telepítése

- Nyissa meg az Ollama letöltési oldalát.

- Válassza ki a platformját (Windows, Linux vagy macOS), és töltse le a megfelelő verziót.

- Telepítse az Ollama-t az operációs rendszerének megfelelő telepítési folyamattal.

Az Open WebUI telepítése és futtatása

Az Open WebUI telepítéséhez használhatja a Python csomagkezelőjét, a pip-et. Kövesse az alábbi lépéseket:

Nyissa meg a terminált, és futtassa az alábbi parancsot az Open WebUI telepítéséhez:

pip install open-webuiA telepítés után frissítse a pip-et a legújabb verzióra az alábbi parancs futtatásával:

python.exe -m pip install --upgrade pipMiután az Open WebUI telepítése befejeződött, indítsa el a szervert az alábbi parancs futtatásával:

open-webui serveSikeres indítás után az Open WebUI az alábbi címen érhető el a böngészőben: http://localhost:8080.

Alternatív megoldásként telepítheti az Open WebUI-t közvetlenül a GitHub-ról a projekt klónozásával. További részletekért tekintse meg az útmutató végén található részt.

Az Ollama konfigurálása és nyelvi modellek letöltése

Az Ollama alapértelmezés szerint a következő útvonalakat használja a nyelvi modellek (LLM-ek) tárolására a rendszerén:

- macOS:

~/.ollama/models - Linux:

/usr/share/ollama/.ollama/models - Windows:

C:\Users\%username%\.ollama\models

Ezt az útvonalat szükség esetén megváltoztathatja. Például Windows esetén használja az alábbi parancsot:

setx OLLAMA_MODELS "D:\ollama_models"Környezeti változók beállítása macOS-en

Ha az Ollama-t macOS alkalmazásként futtatja, a környezeti változókat a launchctl segítségével kell beállítani. Egy változó beállításához használja az alábbi parancsot:

launchctl setenv OLLAMA_MODELS "/new/path/to/models"A változó beállítása után indítsa újra az Ollama alkalmazást, hogy az változások életbe lépjenek.

Környezeti változók beállítása Linuxon

Ha az Ollama-t systemd szolgáltatásként futtatja Linuxon, a környezeti változókat a systemctl segítségével állíthatja be. Az alábbiak szerint járjon el:

Nyissa meg a szolgáltatás konfigurációját az alábbi parancs futtatásával:

sudo systemctl edit ollama.serviceAdja hozzá az alábbi sort a [Service] szekcióhoz:

Environment="OLLAMA_MODELS=/new/path/to/models"Mentse a fájlt, majd töltse újra a systemd konfigurációt, és indítsa újra a szolgáltatást:

sudo systemctl daemon-reload sudo systemctl restart ollama

Nyelvi modellek letöltése és futtatása az Ollama-ban

Nyelvi modellek letöltéséhez és futtatásához az Ollama-ban használja az alábbi parancsokat a terminálban. Ezek a parancsok automatikusan letöltik a modellt, ha az még nincs telepítve:

A LLaMA 3.1 modell letöltése és futtatása a Meta-tól (Facebook):

ollama run llama3.1A Gemma 2 modell letöltése és futtatása a Google-tól:

ollama run gemma2

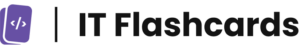

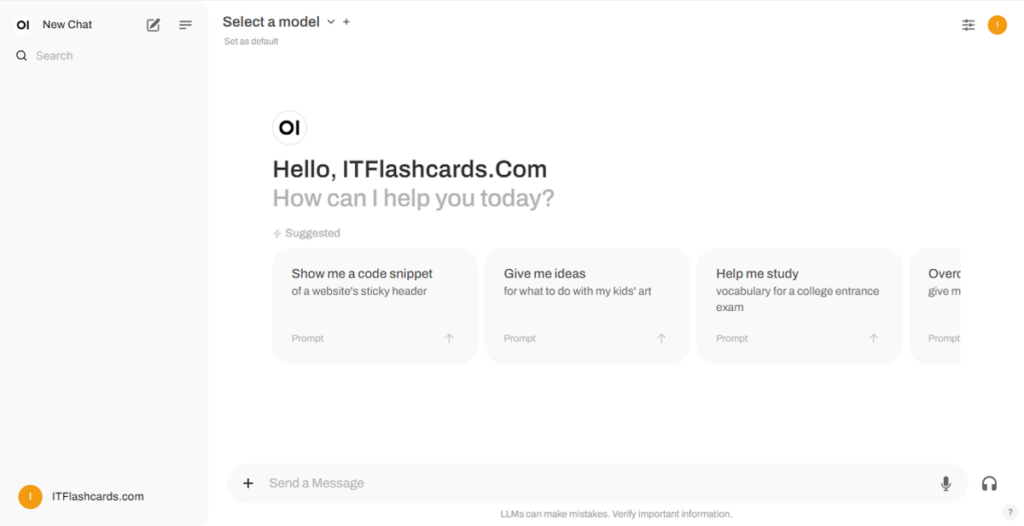

Az Open WebUI használata

Az Open WebUI futtatása után elérhető lesz a böngészőben a következő címen: http://localhost:8080. Miután megnyitotta ezt a címet, be kell jelentkeznie vagy regisztrálnia kell. Új fiók létrehozásához válassza a Regisztráció opciót. Ez a fiók helyileg jön létre, tehát csak ezen a gépen lesz elérhető, más felhasználók nem férnek hozzá az adataihoz.

Ha korábban már elindította az Open WebUI-t, és az Ollama-n keresztül letöltött modellek nem jelennek meg a listában, frissítse az oldalt a modellek elérhetőségének frissítéséhez. Az Open WebUI által kezelt összes adat helyileg a készülékén tárolódik, biztosítva az adatvédelem és az adatok feletti ellenőrzés maximális szintjét.

Az Open WebUI telepítése Git használatával

Ha az Open WebUI-t a GitHub-ról klónozva, manuálisan szeretné telepíteni és kezelni, kövesse az alábbi lépéseket:

Nyisson meg egy terminált, és navigáljon ahhoz a könyvtárhoz, ahová a tárolót klónozni szeretné.

Klónozza az Open WebUI tárolót a Git segítségével:

git clone https://github.com/open-webui/open-webui.gitLépjen be a projekt könyvtárába:

cd open-webui/Másolja az .env fájlt:

cp -RPp .env.example .envÉpítse fel a frontendet a Node.js használatával:

npm install npm run buildLépjen be a

backendkönyvtárba:cd ./backend(Opcionális) Hozzon létre és aktiváljon egy Conda környezetet:

conda create --name open-webui-env python=3.11 conda activate open-webui-envTelepítse a Python-függőségeket:

pip install -r requirements.txt -UIndítsa el az alkalmazást:

bash start.sh

Windows esetén:

Nyisson meg egy terminált, és navigáljon ahhoz a könyvtárhoz, ahová a tárolót klónozni szeretné.

Klónozza az Open WebUI tárolót a Git segítségével:

git clone https://github.com/open-webui/open-webui.gitLépjen be a projekt könyvtárába:

cd open-webuiMásolja az .env fájlt:

copy .env.example .envÉpítse fel a frontendet a Node.js használatával:

npm install npm run buildLépjen be a backend könyvtárba:

cd .\backend(Opcionális) Hozzon létre és aktiváljon egy Conda környezetet:

conda create --name open-webui-env python=3.11 conda activate open-webui-envTelepítse a Python-függőségeket:

pip install -r requirements.txt -UIndítsa el az alkalmazást:

start_windows.bat

Ollama + Open WebUI összefoglaló

Ezen útmutató követésével sikeresen futtathatja az Ollama-t és az Open WebUI-t (Docker nélkül) helyben, problémamentesen. Ha bármilyen hibával vagy nehézséggel találkozik, kérem, hagyjon egy megjegyzést, és a lehető legjobban segítek.