Ollama + Open WebUI: Ένας τρόπος για να τρέξετε LLMs τοπικά σε Windows, Linux ή macOS (χωρίς Docker)

Εκτιμώμενος χρόνος ανάγνωσης: 6 λεπτά

Εισαγωγή

Αυτός ο οδηγός θα σας δείξει πώς να ρυθμίσετε και να εκτελέσετε εύκολα μεγάλα γλωσσικά μοντέλα (LLMs) τοπικά χρησιμοποιώντας το Ollama και το Open WebUI σε Windows, Linux ή macOS – χωρίς την ανάγκη για Docker. Το Ollama παρέχει τοπική εκτέλεση μοντέλων, ενώ το Open WebUI είναι ένα περιβάλλον χρήστη που απλοποιεί την αλληλεπίδραση με αυτά τα μοντέλα. Η εμπειρία είναι παρόμοια με τη χρήση περιβαλλόντων όπως το ChatGPT, το Google Gemini ή το Claude AI.

Γιατί να τρέξετε το Open WebUI χωρίς Docker;

Η εκτέλεση του Open WebUI χωρίς Docker σας επιτρέπει να αξιοποιείτε τους πόρους του υπολογιστή σας πιο αποδοτικά. Χωρίς τους περιορισμούς των περιβάλλοντων κοντέινερ, όλη η διαθέσιμη μνήμη, η ισχύς της CPU και ο αποθηκευτικός χώρος μπορούν να αφιερωθούν πλήρως στην εκτέλεση της εφαρμογής. Αυτό είναι ιδιαίτερα σημαντικό όταν εργάζεστε με μοντέλα που απαιτούν πολλούς πόρους, όπου κάθε στοιχείο απόδοσης είναι κρίσιμο.

Για παράδειγμα, εάν χρησιμοποιείτε το Open WebUI για να αλληλεπιδράσετε με μεγάλα γλωσσικά μοντέλα, η φυσική εκτέλεση μπορεί να οδηγήσει σε ταχύτερους χρόνους επεξεργασίας και πιο ομαλή απόδοση, καθώς δεν υπάρχει το επιπλέον φορτίο του Docker για τη διαχείριση του κοντέινερ. Με την εγγενή εκτέλεση, κερδίζετε επίσης:

- Απλούστερη ρύθμιση: Αποφεύγετε την πολυπλοκότητα της ρύθμισης και διαχείρισης κοντέινερ Docker, κάτι που μπορεί να είναι ιδιαίτερα επωφελές για χρήστες που προτιμούν μια πιο απλή και άμεση εγκατάσταση.

- Βελτιωμένη απόδοση: Χωρίς την εικονικοποίηση του Docker, υπάρχει πιο άμεση σύνδεση με τους πόρους του συστήματός σας, κάτι που μπορεί να οδηγήσει σε καλύτερη απόδοση της εφαρμογής.

- Άμεση πρόσβαση στους πόρους του συστήματος: Έχετε άμεσο έλεγχο στις διαδρομές αρχείων, τις ρυθμίσεις και τις διαμορφώσεις του συστήματος, γεγονός που διευκολύνει την αντιμετώπιση προβλημάτων και την προσαρμογή.

Προαπαιτούμενα

Πριν ξεκινήσετε, βεβαιωθείτε ότι έχετε εγκαταστήσει τα παρακάτω στο σύστημά σας:

- Python: Απαραίτητο για την εκτέλεση του Open WebUI.

Βεβαιωθείτε ότι χρησιμοποιείτε Python 3.11.X. Για παράδειγμα, η έκδοση 3.11.6 λειτουργεί καλά. Η πιο πρόσφατη έκδοση του Python, 3.12.7, δεν είναι συμβατή με την τρέχουσα έκδοση του Open WebUI.

Μπορείτε να κατεβάσετε το Python εδώ. Βεβαιωθείτε ότι επιλέγετε τη σωστή έκδοση για το λειτουργικό σας σύστημα. Το Python είναι μια ευέλικτη γλώσσα προγραμματισμού που χρησιμοποιείται ευρέως στην τεχνητή νοημοσύνη και τη μηχανική μάθηση, συμπεριλαμβανομένης της ανάπτυξης και λειτουργίας μεγάλων γλωσσικών μοντέλων (LLMs). Εάν θέλετε να αναπτύξετε τις δεξιότητές σας σε αυτόν τον τομέα, μην ξεχάσετε να δείτε τις κάρτες εκμάθησης Python για γρήγορη και αποτελεσματική μάθηση.

Εγκατάσταση του Ollama

- Μεταβείτε στη σελίδα λήψης του Ollama.

- Επιλέξτε την πλατφόρμα σας (Windows, Linux ή macOS) και κατεβάστε την κατάλληλη έκδοση.

- Εγκαταστήστε το Ollama χρησιμοποιώντας τη συνήθη διαδικασία εγκατάστασης για την πλατφόρμα σας.

Εγκατάσταση και εκτέλεση του Open WebUI

Για να εγκαταστήσετε το Open WebUI, μπορείτε να χρησιμοποιήσετε τον διαχειριστή πακέτων pip του Python. Ακολουθήστε τα παρακάτω βήματα:

Ανοίξτε το τερματικό σας και εκτελέστε την ακόλουθη εντολή για να εγκαταστήσετε το Open WebUI:

pip install open-webuiΜετά την εγκατάσταση, ενημερώστε το pip στην τελευταία έκδοση εκτελώντας την εξής εντολή:

python.exe -m pip install --upgrade pipΜόλις εγκατασταθεί το Open WebUI, ξεκινήστε τον διακομιστή χρησιμοποιώντας την ακόλουθη εντολή:

open-webui serveΜετά την επιτυχή εκκίνηση του Open WebUI, μπορείτε να το έχετε πρόσβαση μέσω του προγράμματος περιήγησής σας στη διεύθυνση: http://localhost:8080.

Επιπλέον, εάν προτιμάτε, μπορείτε να εγκαταστήσετε το Open WebUI κλωνοποιώντας το έργο απευθείας από το GitHub. Για περισσότερες λεπτομέρειες, δείτε την ενότητα στο τέλος αυτού του οδηγού.

Διαμόρφωση του Ollama και λήψη γλωσσικών μοντέλων

Από προεπιλογή, το Ollama ορίζει τις ακόλουθες διαδρομές για την αποθήκευση γλωσσικών μοντέλων (LLMs) στο σύστημά σας:

- macOS:

~/.ollama/models - Linux:

/usr/share/ollama/.ollama/models - Windows:

C:\Users\%username%\.ollama\models

Μπορείτε να αλλάξετε αυτήν τη διαδρομή εάν χρειάζεται. Για παράδειγμα, στα Windows, χρησιμοποιήστε την ακόλουθη εντολή:

setx OLLAMA_MODELS "D:\ollama_models"Ρύθμιση μεταβλητών περιβάλλοντος στο macOS

Εάν εκτελείτε το Ollama ως εφαρμογή macOS, οι μεταβλητές περιβάλλοντος θα πρέπει να ρυθμιστούν χρησιμοποιώντας το launchctl. Για να ορίσετε μια μεταβλητή, χρησιμοποιήστε την ακόλουθη εντολή:

launchctl setenv OLLAMA_MODELS "/new/path/to/models"After setting the variable, restart the Ollama application for the changes to take effect.

Ρύθμιση μεταβλητών περιβάλλοντος στο Linux

Για τους χρήστες Linux που εκτελούν το Ollama ως υπηρεσία systemd, μπορείτε να ρυθμίσετε τις μεταβλητές περιβάλλοντος χρησιμοποιώντας το systemctl. Δείτε πώς να το κάνετε:

Ανοίξτε τη διαμόρφωση της υπηρεσίας εκτελώντας:

sudo systemctl edit ollama.serviceΣτην ενότητα [Service], προσθέστε την ακόλουθη γραμμή:

Environment="OLLAMA_MODELS=/new/path/to/models"Αποθηκεύστε το αρχείο, στη συνέχεια επαναφορτώστε το systemd και επανεκκινήστε την υπηρεσία:

sudo systemctl daemon-reload sudo systemctl restart ollama

Λήψη και εκτέλεση γλωσσικών μοντέλων στο Ollama

Για να κατεβάσετε και να εκτελέσετε γλωσσικά μοντέλα στο Ollama, χρησιμοποιήστε τις ακόλουθες εντολές στο τερματικό. Αυτές οι εντολές θα κατεβάσουν αυτόματα το μοντέλο εάν δεν είναι ήδη εγκατεστημένο:

Για να κατεβάσετε και να εκτελέσετε το μοντέλο LLaMA 3.1 από τη Meta (Facebook):

ollama run llama3.1Για να κατεβάσετε και να εκτελέσετε το μοντέλο Gemma 2 από την Google:

ollama run gemma2

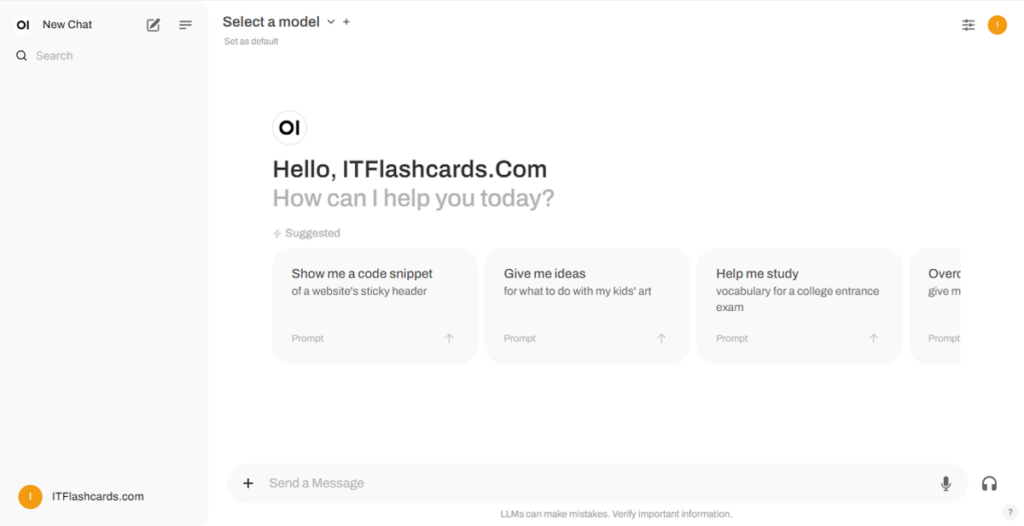

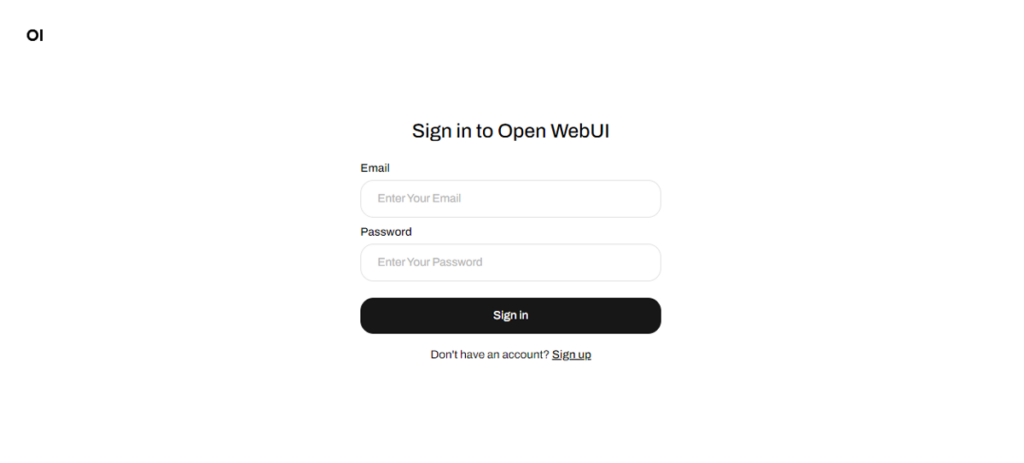

Χρήση του Open WebUI

Μόλις το Open WebUI εκτελείται, μπορείτε να το αποκτήσετε μέσω http://localhost:8080. Αφού μεταβείτε σε αυτήν τη διεύθυνση, θα σας ζητηθεί να συνδεθείτε ή να εγγραφείτε. Για να δημιουργήσετε έναν νέο λογαριασμό, επιλέξτε την επιλογή Εγγραφή (Sign Up). Αυτός ο λογαριασμός δημιουργείται τοπικά, πράγμα που σημαίνει ότι είναι διαθέσιμος μόνο σε αυτόν τον υπολογιστή και κανένας άλλος χρήστης στο σύστημά σας δεν θα έχει πρόσβαση στα δεδομένα σας.

Εάν έχετε ξεκινήσει προηγουμένως το Open WebUI και τα μοντέλα που κατεβάσατε μέσω του Ollama δεν εμφανίζονται στη λίστα, ανανεώστε τη σελίδα για να ενημερώσετε τα διαθέσιμα μοντέλα. Όλα τα δεδομένα που διαχειρίζεται το Open WebUI αποθηκεύονται τοπικά στη συσκευή σας, εξασφαλίζοντας την ιδιωτικότητα και τον έλεγχο των μοντέλων και των αλληλεπιδράσεών σας.

Εγκατάσταση του Open WebUI χρησιμοποιώντας το Git

Εάν θέλετε να εγκαταστήσετε το Open WebUI κλωνοποιώντας το έργο από το GitHub και να το διαχειριστείτε χειροκίνητα, ακολουθήστε αυτά τα βήματα:

Προαπαιτούμενα:

- Git: Βεβαιωθείτε ότι έχετε εγκατεστημένο το Git στο σύστημά σας. Μπορείτε να το κατεβάσετε από εδώ.

- Anaconda: Συνιστάται η χρήση του Anaconda για τη διαχείριση του περιβάλλοντος Python σας. Μπορείτε να κατεβάσετε και να εγκαταστήσετε το Anaconda από εδώ.

Οδηγίες εγκατάστασης:

Για Linux/macOS:

Ανοίξτε ένα τερματικό και μεταβείτε στον κατάλογο όπου θέλετε να κλωνοποιήσετε το αποθετήριο.

Κλωνοποιήστε το αποθετήριο Open WebUI χρησιμοποιώντας το Git:

git clone https://github.com/open-webui/open-webui.gitΜεταβείτε στον κατάλογο του έργου:

cd open-webui/Αντιγράψτε το αρχείο .env:

cp -RPp .env.example .envΔημιουργήστε το frontend χρησιμοποιώντας το Node.js:

npm install npm run buildΜεταβείτε στον κατάλογο του backend:

cd ./backend(Προαιρετικό) Δημιουργήστε και ενεργοποιήστε ένα περιβάλλον Conda:

conda create --name open-webui-env python=3.11 conda activate open-webui-envΕγκαταστήστε τις εξαρτήσεις του Python:

pip install -r requirements.txt -UΞεκινήστε την εφαρμογή:

bash start.sh

Για Windows:

Ανοίξτε ένα τερματικό και μεταβείτε στον κατάλογο όπου θέλετε να κλωνοποιήσετε το αποθετήριο.

Κλωνοποιήστε το αποθετήριο Open WebUI χρησιμοποιώντας το Git:

git clone https://github.com/open-webui/open-webui.gitΜεταβείτε στον κατάλογο του έργου:

cd open-webuiΑντιγράψτε το αρχείο .env:

copy .env.example .envΔημιουργήστε το frontend χρησιμοποιώντας το Node.js:

npm install npm run buildΜεταβείτε στον κατάλογο του backend:

cd .\backend(Προαιρετικό) Δημιουργήστε και ενεργοποιήστε ένα περιβάλλον Conda:

conda create --name open-webui-env python=3.11 conda activate open-webui-envΕγκαταστήστε τις εξαρτήσεις του Python:

pip install -r requirements.txt -UΞεκινήστε την εφαρμογή:

start_windows.bat

Ollama + Open WebUI: Περίληψη

Ακολουθώντας αυτόν τον οδηγό, θα πρέπει να μπορείτε να εκτελέσετε με επιτυχία το Ollama και το Open WebUI (χωρίς Docker) τοπικά χωρίς προβλήματα. Ωστόσο, εάν αντιμετωπίσετε σφάλματα ή δυσκολίες κατά τη διάρκεια της διαδικασίας, μη διστάσετε να αφήσετε ένα σχόλιο, και θα κάνω το καλύτερο δυνατό για να σας βοηθήσω.