Ollama + Open WebUI: Jak spustit LLM lokálně na Windows, Linuxu nebo macOS (bez Dockeru)

Odhadovaný čas čtení: 5 minut

Úvod

Tato příručka vám ukáže, jak snadno nastavit a spustit velké jazykové modely (LLM) lokálně pomocí Ollama a Open WebUI na Windows, Linuxu nebo macOS – bez potřeby Dockeru. Ollama poskytuje lokální inferenci modelů a Open WebUI je uživatelské rozhraní, které zjednodušuje interakci s těmito modely. Zkušenost je podobná používání rozhraní, jako je ChatGPT, Google Gemini nebo Claude AI.

Proč spustit Open WebUI bez Dockeru?

Spuštění Open WebUI bez Dockeru vám umožní efektivněji využívat zdroje vašeho počítače. Bez omezení kontejnerových prostředí může být veškerá dostupná paměť systému, výkon procesoru a úložiště plně věnována běhu aplikace. To je obzvláště důležité při práci s náročnými modely, kde záleží na každém kousku výkonu.

Například pokud používáte Open WebUI pro práci s velkými jazykovými modely, nativní spuštění může vést k rychlejšímu zpracování a plynulejšímu výkonu, protože Docker nevyžaduje dodatečné zdroje pro správu kontejneru. Při nativním spuštění také získáte:

- Jednodušší nastavení: Vyhnete se složitosti nastavování a správy Docker kontejnerů, což může být obzvláště výhodné pro uživatele, kteří preferují jednodušší a přímější instalaci.

- Lepší výkon: Bez virtualizace Dockeru je přístup k systémovým zdrojům přímější, což může vést k lepšímu výkonu aplikace.

- Přímý přístup k systémovým zdrojům: Máte přímou kontrolu nad cestami k souborům, nastavením a systémovými konfiguracemi, což usnadňuje řešení problémů a přizpůsobení.

Předpoklady

Než začnete, ujistěte se, že máte na svém systému nainstalováno následující:

- Python: Potřebný pro spuštění Open WebUI.

Ujistěte se, že používáte Python 3.11.X. Verze 3.11.6 funguje dobře, například. Nejnovější verze Pythonu, 3.12.7, není kompatibilní s aktuální verzí Open WebUI.

Python si můžete stáhnout zde. Ujistěte se, že vyberete správnou verzi pro váš operační systém. Python je univerzální programovací jazyk, široce používaný v oblasti umělé inteligence a strojového učení, včetně vývoje a provozu velkých jazykových modelů (LLM). Pokud chcete rozvíjet své dovednosti v této oblasti, nezapomeňte se podívat na naše kartičky s Pythonem pro rychlý a efektivní způsob učení.

Instalace Ollama

- Přejděte na stránku ke stažení Ollama.

- Vyberte si svou platformu (Windows, Linux nebo macOS) a stáhněte si odpovídající verzi.

- Nainstalujte Ollama pomocí standardního instalačního procesu pro vaši platformu

Instalace a spuštění Open WebUI

K instalaci Open WebUI můžete použít správce balíčků Pythonu, pip. Postupujte podle těchto kroků:

Otevřete terminál a spusťte následující příkaz k instalaci Open WebUI:

pip install open-webuiPo instalaci aktualizujte pip na nejnovější verzi spuštěním následujícího příkazu:

python.exe -m pip install --upgrade pipJakmile je Open WebUI nainstalováno, spusťte server pomocí následujícího příkazu:

open-webui servePo úspěšném spuštění Open WebUI k němu můžete přistupovat ve svém prohlížeči na adrese: http://localhost:8080.

Pokud dáváte přednost, můžete také nainstalovat Open WebUI klonováním projektu přímo z GitHubu. Pro více informací si přečtěte sekci na konci této příručky.

Konfigurace Ollama a stahování jazykových modelů

Ve výchozím nastavení Ollama nastaví následující cesty pro ukládání jazykových modelů (LLM) ve vašem systému:

- macOS:

~/.ollama/models - Linux:

/usr/share/ollama/.ollama/models - Windows:

C:\Users\%username%\.ollama\models

Tuto cestu můžete v případě potřeby změnit. Například na Windows použijte následující příkaz:

setx OLLAMA_MODELS "D:\ollama_models"Nastavení proměnných prostředí na macOS

Pokud spouštíte Ollama jako aplikaci na macOS, proměnné prostředí by měly být nastaveny pomocí launchctl. Pro nastavení proměnné použijte následující příkaz:

launchctl setenv OLLAMA_MODELS "/new/path/to/models"Po nastavení proměnné restartujte aplikaci Ollama, aby se změny projevily.

Nastavení proměnných prostředí na Linuxu

Pro uživatele Linuxu, kteří spouštějí Ollama jako službu systemd, můžete proměnné prostředí nastavit pomocí systemctl. Zde je postup, jak to udělat:

Otevřete konfiguraci služby spuštěním následujícího příkazu:

sudo systemctl edit ollama.serviceV sekci [Service] přidejte následující řádek:

Environment="OLLAMA_MODELS=/new/path/to/models"Uložte soubor, poté znovu načtěte systemd a restartujte službu:

sudo systemctl daemon-reload sudo systemctl restart ollama

Stahování a spuštění jazykových modelů v Ollama

Pro stažení a spuštění jazykových modelů v Ollama použijte následující příkazy v terminálu. Tyto příkazy automaticky stáhnou model, pokud již není nainstalován:

Pro stažení a spuštění modelu LLaMA 3.1 od Meta (Facebook):

ollama run llama3.1Pro stažení a spuštění modelu Gemma 2 od Google:

ollama run gemma2

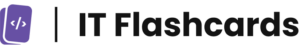

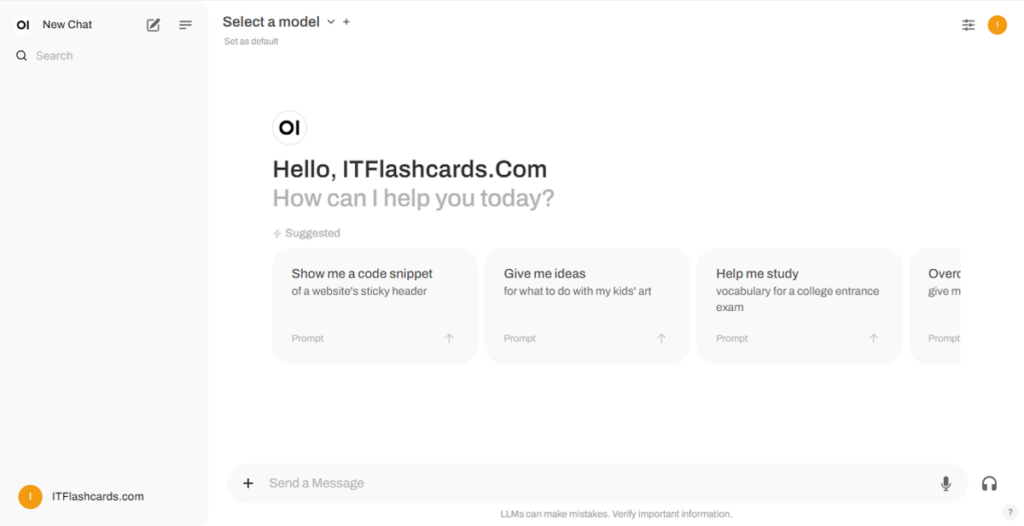

Používání Open WebUI

Jakmile Open WebUI běží, můžete k němu přistupovat přes http://localhost:8080. Po přechodu na tuto adresu budete vyzváni k přihlášení nebo registraci. Pro vytvoření nového účtu vyberte možnost Sign Up. Tento účet je vytvořen lokálně, což znamená, že je dostupný pouze na tomto počítači a žádný jiný uživatel ve vašem systému nebude mít přístup k vašim datům.

Pokud jste již dříve spustili Open WebUI a modely stažené přes Ollama se nezobrazují v seznamu, obnovte stránku, aby se aktualizovaly dostupné modely. Veškerá data spravovaná v Open WebUI jsou uložena lokálně na vašem zařízení, což zajišťuje soukromí a kontrolu nad vašimi modely a interakcemi.

Instalace Open WebUI pomocí Gitu

Pokud chcete nainstalovat Open WebUI klonováním projektu z GitHubu a spravovat ho ručně, postupujte podle těchto kroků:

Předpoklady:

- Git: Ujistěte se, že máte na svém systému nainstalovaný Git. Můžete si ho stáhnout zde.

- Anaconda: Doporučuje se používat Anacondu pro správu vašeho prostředí Pythonu. Můžete si stáhnout a nainstalovat Anacondu zde.

Instalační instrukce:

Pro Linux/macOS:

Otevřete terminál a přejděte do adresáře, kam chcete naklonovat repozitář.

Naklonujte repozitář Open WebUI pomocí Gitu:

git clone https://github.com/open-webui/open-webui.gitPřejděte do adresáře projektu:

cd open-webui/Zkopírujte soubor .env:

cp -RPp .env.example .envVytvořte frontend pomocí Node.js:

npm install npm run buildPřejděte do adresáře backendu:

cd ./backend(Volitelné) Vytvořte a aktivujte prostředí Conda:

conda create --name open-webui-env python=3.11 conda activate open-webui-envNainstalujte závislosti Pythonu:

pip install -r requirements.txt -USpusťte aplikaci:

bash start.sh

Pro Windows:

Otevřete terminál a přejděte do adresáře, kam chcete naklonovat repozitář.

Naklonujte repozitář Open WebUI pomocí Gitu:

git clone https://github.com/open-webui/open-webui.gitPřejděte do adresáře projektu:

cd open-webuiZkopírujte soubor .env:

copy .env.example .envVytvořte frontend pomocí Node.js:

npm install npm run buildPřejděte do adresáře backendu:

cd .\backend(Volitelné) Vytvořte a aktivujte prostředí Conda:

conda create --name open-webui-env python=3.11 conda activate open-webui-envNainstalujte závislosti Pythonu:

pip install -r requirements.txt -USpusťte aplikaci:

start_windows.bat

Shrnutí Ollama + Open WebUI

Podle této příručky byste měli být schopni úspěšně spustit Ollama a Open WebUI (bez Dockeru) lokálně bez jakýchkoli problémů. Pokud však narazíte na chyby nebo potíže, neváhejte zanechat komentář a udělám vše pro to, abych vám pomohl.